Depuis environ trente ans, des changements spectaculaires se sont produits dans l’espace électoral en Europe et aux États-Unis. Dans un premier temps, à partir du milieu des années 1980, on voit émerger dans toute l’Europe de l’Ouest, puis dans plusieurs pays d’Europe de l’Est, des partis « populistes » (souverainistes, xénophobes, anti-européens, anti-mondialisation), dans une distribution spatiale inédite. Puis, dans les années 1990 et jusqu’à aujourd’hui (référendums français de 1992 et 2005, référendums de 1992 en Suisse et de 1994 en Norvège, Brexit en 2016), cette même distribution se retrouve dans des votes thématiques, notamment ceux qui portent sur l’Europe, mais pas seulement. Le cas suisse, avec ses votations fréquentes, montre qu’il existe une famille de référendums sur des sujets très divers ayant en commun d’impliquer, dans les discours des acteurs politiques, des enjeux d’« ouverture » ou de « fermeture » et que, dans tous les cas, les votes reproduisent ces mêmes configurations géographiques. Enfin, à partir de 2000, ce sont des élections généralistes dont les résultats donnent, une fois de plus, le même type de carte. C’est notamment le cas des cinq dernières élections présidentielles états-uniennes (2000, 2004, 2008, 2012, 2016), de la dernière élection présidentielle autrichienne (2016) et de la dernière élection présidentielle française (2017). Les élections européennes de 2019 ont synthétisé cette tendance (Lévy et al. 2019). Quant au mouvement des Gilets jaunes (2018-2019), il a manifesté avec une grande netteté l’émergence d’un type de contestation politique inédite, localisée dans des espaces péri- et infra-urbains, qui s’est révélée incapable de faire jonction avec le monde des centres et même des banlieues, où les niveaux de revenu et de précarité semblaient pourtant comparables à ceux du « peuple des ronds-points ».

Quelle est cette nouvelle géographie ? Le changement le plus impressionnant, c’est ce qu’on peut appeler le théorème des gradients et qui n’est qu’une formalisation à visée descriptive. Celui-ci s’exprime d’abord par le premier énoncé suivant (1).

Si, dans une aire urbaine donnée AUi, c représente le vote du centre, b, celui de la banlieue et p, celui du périurbain, alors, quelle que soit AU, le vote d’« ouverture » v›‹ sera toujours supérieur dans le centre à celui de la banlieue et dans la banlieue à celui du périurbain, avec un résultat inverse pour le vote de « fermeture » v‹›.

(1)

∀AU= c + b + p,

v›‹cAUi > v›‹bAUi > v›‹pAUi

et v‹›cAUi < v‹›bAUi < v‹›pAUi

Dans tous ces scrutins, les zones centrales des grandes villes votent de manière similaire et les zones périurbaines (ou dans le cas des États-Unis, suburbaines et ex-urbaines) également. Les gradients d’urbanité définis par la position relative au sein ou en dehors des aires urbaines (centre, banlieue/inner city, Suburbia/périurbain, hypo-urbain/exurbain, infra-urbain) sont fortement prédictifs de ces votes. Il ne s’agit pas d’une opposition entre les métropoles et le reste du territoire, mais d’une différenciation dont les traits les plus marquants sont les contrastes internes aux grandes aires urbaines.

À ces différences relatives internes à chaque aire urbaine, on peut ajouter une régularité absolue, mais un peu moins systématique, portant sur la taille des aires urbaines. C’est le second énoncé (2) : plus le système urbain est peuplé, plus les votes d’« ouverture » sont forts et les votes de « fermeture » faibles dans l’ensemble de l’aire urbaine.

(2)

∀ AUi >AUj,

v›‹AUi > v›‹AUj

et v‹›AUi < v‹›AUj

Par exemple, le vote xénophobe est, depuis qu’il se manifeste massivement, à partir des années 1990, dans l’ensemble plus faible en Île-de-France que dans l’aire urbaine du Mans ou de Reims. Cette règle (2) est conforme à l’idée que les gradients d’urbanité ont une composante absolue : une grande ville produit, toutes choses égales par ailleurs, davantage d’urbanité qu’une petite. Mais ce « toutes choses égales par ailleurs » bute sur le fait que d’autres logiques que celles de la masse différencient les configurations urbaines : à masse égale, on peut rencontrer des aires urbaines qui diffèrent par le couple densité + diversité, générateur d’urbanité. Ainsi, les bassins industriels ou les stations touristiques se distinguent des villes plus généralistes.

En outre, l’enjeu du vote lui-même peut activer des différenciations géographiques d’un autre ordre et d’une autre échelle. Ainsi peut-on supposer que les électeurs des régions qui, historiquement, ont supporté le plus mal la centralisation de l’État national, telles que l’Écosse ou la Bretagne, voient plutôt d’un bon œil l’« ouverture » vers l’Europe, tandis que de nouvelles identités politiques, plutôt « fermées », émergent, comme sur le littoral méditerranéen français ou dans la plaine du Pô. Cependant, les écarts à ce second principe n’affaiblissent pas, mais modulent seulement le premier et n’invalident donc pas l’énoncé (1). Celui-ci, en se référant à une aire urbaine quelconque AUi, admet que le niveau moyen du vote de chaque aire urbaine puisse varier. Ce qui, en revanche, apparaît comme une règle n’admettant que très peu d’exceptions, c’est que, quelle que soit la moyenne des votes de la région à laquelle appartient une aire urbaine, les gradients d’urbanité sont toujours générateurs de différences de l’intérieur vers l’extérieur, décroissantes pour les attitudes « ouvertes », croissantes pour les attitudes « fermées ».

Ces géographies électorales diffèrent des celles d’époques précédentes, qui avaient souvent persisté sur de longues durées et qui peuvent réapparaître quand le vote porte sur d’autres enjeux, notamment quand ils relèvent d’un affrontement entre une gauche et une droite traditionnelles à propos de la puissance de l’État-providence. Dans les cas qui nous intéressent, ces oppositions longtemps stables semblent s’être effacées.

Nouveaux modèles spatiaux urbains.

Une fois ce constat fait, le premier niveau d’interprétation qu’on peut proposer reste modeste sur le plan conceptuel : il consiste à comparer les cartes électorales à d’autres cartes configurant d’autres réalités sociales que le vote. Ainsi la ressemblance entre les gradients d’urbanité de même valeur, mais situés à distance les uns des autres, évoque l’achèvement de l’urbanisation absolue dans les pays développés et la possibilité accrue de choix, pour la majorité de la population des pays développés, d’un modèle d’habiter. Les espaces contemporains apparaissent comme des archipels [1] d’aires urbaines dont les géographies internes et externes des « îles » sont très similaires, pour peu que leur taille soit comparable. La capacité, plus forte qu’auparavant, pour les personnes se situant dans un vaste groupe moyen d’arbitrer en faveur d’un mode de vie plutôt que d’un autre (en Europe : centre/banlieue/périurbain/hypo-urbain/infra-urbain, locataire/propriétaire, mobilité publique/privée, ménage de une/deux/plusieurs personnes, etc.) fait de l’espace le résultat de spatialités, c’est-à-dire d’actions géographiques au moins pour partie volontaires. En conséquence, l’espace du choix politique mériterait d’être rapproché de l’espace du choix d’habiter, tous deux appartenant au registre des décisions stratégiques majeures pour les individus-habitants.

Ces nouvelles cartes incitent aussi à se pencher sur les modèles descriptifs généraux des espaces urbains, disponibles dans la littérature scientifique. En 1925, Ernest Burgess avait proposé pour Chicago un modèle concentrique qui pouvait s’appliquer à de nombreuses autres villes nord-américaines, mais aussi, moyennant quelques correctifs, aux villes européennes. Dans ce modèle, l’éloignement progressif par rapport au centre était prédictif des localisations tant des secteurs d’activité que des groupes sociaux. En 1939, Homer Hoyt présentait une alternative avec le modèle sectoriel, par lequel il rendait compte d’une certaine homogénéité, tant sociologique qu’économique, à l’intérieur d’une zone définie par une direction cardinale à partir du centre, indépendamment de la distance. Enfin, en 1945, Chauncy Harris et Edward Ullman avaient identifié un troisième modèle, en noyaux multiples, qui représentait les localisations par petites unités indépendantes disposées de manière aléatoire sur l’ensemble de l’espace urbain. Le deuxième modèle était la conséquence de l’accroissement de l’accessibilité des différents lieux urbains à partir du centre, tandis que le troisième résultait à la fois de la généralisation de la motorisation privée et de l’affaiblissement des centres historiques, surtout dans les villes nord-américaines sans passé pré-automobile.

Or, les nouvelles cartes électorales évoquent clairement de nouveau un modèle concentrique, qui fait écho à d’autres tendances de l’urbanisation récente en Europe comme aux États-Unis. Celles-ci se caractérisent simultanément i. par une attractivité renouvelée des centres historiques et ii. par la persistance de mouvements centrifuges (périurbanisation en Europe et nouveaux types d’urbanisation périphérique en Amérique du Nord). Cela aboutit à des configurations dans lesquelles les activités les plus créatives et les maxima de mixité sociologique se trouvent au centre, qui, s’étendant à la proche banlieue, concentre à la fois une partie des habitants à capital social élevé et la majorité des pauvres, tandis que les zones externes (Suburbia nord-américaine et périurbain européen) présentent des entités socialement et fonctionnellement plus homogènes avec des résidents plus aisés en moyenne que dans l’ensemble de l’aire urbaine.

Les transformations de la géographie électorale invitent donc à connecter ces nouvelles cartes à d’autres cartes portant sur les dynamiques spatiales récentes et à se demander si les choix politiques n’expriment pas, selon des modalités spécifiques, des transformations plus globales du social. On constate en tout état de cause que l’analyse de ces changements conduit qui veut les comprendre à des renouvellements de méthode, notamment à de nouveaux usages de la carte, et de problématique, en plaçant les « petits » acteurs, les individus-citoyens-habitants, au centre du questionnement.

On pourrait aller plus loin et formuler des hypothèses permettant de construire un modèle explicatif de ces mutations. À ce stade d’esquisse, parmi plusieurs pistes possibles, je propose l’idée que les votes dont il est question ici seraient des choix politiques à enjeu communautaire/post-communautaire. S’y joueraient l’allégeance ou le refus d’allégeance personnelle à des groupes non choisis et irréversibles, comme la famille, la nation ou la religion et, en conséquence, la valorisation que l’on accorderait à la dynamique autonome des individus, porteuse à la fois de liberté et de risque, dans une société elle-même en mouvement et confrontée à d’autres sociétés. Dans cette approche, il y a à la fois beaucoup d’espaces : des environnements à dominante réticulaire (plutôt que territoriale) et interscalaires (plutôt que dominés par l’échelle unique de l’État-nation), mais aussi beaucoup de spatialités : ce que chaque individu revendique et, jusqu’à un certain point pratique, comme liberté spatiale stratégique ou au contraire comme attachement à un ensemble fixe de lieux. Ces hypothèses proviennent notamment de recherches empiriques et théoriques menées sur la justice spatiale (Lévy, Fauchille et Póvoas 2018). On retrouverait donc dans la carte des votes une relation entre les attentes politiques générales des électeurs en matière d’espace et les choix spatiaux concrets des habitants, tels qu’ils se manifestent dans leurs arbitrages de localisation. C’est cette rencontre inédite entre l’acteur-habitant et l’acteur-électeur qui ferait la spécificité des configurations émergentes.

Capitaux sociaux en mouvement.

Prendre en compte la dimension spatiale de l’individu acteur contemporain ne signifie pas opposer une raison géographique à une raison sociologique. Il s’agit plutôt d’intégrer à l’analyse sociologique (qui porte sur les groupes sociaux, les personnes qui les composent et les interactions entre tous ces opérateurs) tout ce qui peut y prendre sens, en allant au-delà de la seule dotation en capital économique. Le mouvement des Gilets jaunes a montré qu’il était possible de constituer un groupe politique cohérent sur la base non d’une position sur un axe unique mais sur une relation entre capital économique et capital culturel. En effet, si, dans l’ensemble, le niveau de revenus médian des participants au mouvement s’approchait de la médiane de l’ensemble des Français, leur niveau de diplôme était significativement plus bas. C’est une caractéristique qu’on rencontre dans l’électorat du Front national/Rassemblement national et, plus encore, dans celui de Donald Trump. On peut donc réfléchir à des typologies fondées sur les différentes espèces de capitaux : C<É, É>C, É=C…, même si la mesure de chacune des espèces de capital social n’est pas évidente (l’articulation entre revenu et patrimoine pour l’économique ; les au-delàs du capital scolaire pour le culturel), et leur commensuration moins encore.

C’est d’autant plus intéressant que ces deux types de capitaux renvoient à un rapport spécifique au monde social. Le capital économique porte sur des biens monétaires, totalement privatisables et dont le propriétaire a la pleine possession. Le capital culturel concerne au contraire des biens publics (Lévy, Fauchille et Póvoas 2018), coproduits par son consommateur et la société, et dont le détenteur ne peut pas viser à l’exclusivité. Le capital culturel, qui intègre à la fois l’éducation et la culture, forme un bloc avec d’autres espèces de capitaux comparables, comme le capital spatial, qui porte aussi sur les biens publics, tandis que le capital relationnel (l’ensemble des liens-ressources avec d’autres individus ou d’autres groupes, que Pierre Bourdieu nommait « capital social ») se situe entre les deux ensembles, mais plus près du capital économique. Ces deux types de construction sont aussi deux attitudes dans la relation individu/société. Les biens privés invitent à une posture libertarienne : on doit protéger son capital économique contre toutes sortes d’érosions, notamment fiscales, venant de l’État et, à cette fin, soustraire ses biens à son regard. Les biens publics impliquent une rencontre entre une capacité – la capability d’Amartya Sen (2012) – et un service public (la contribution de la société). Il en résulte aussi une opposition dans le rapport au changement de soi. Le capital en biens privés est objectal : il constitue une addition de ressources supplémentaires qui n’affectent pas directement l’identité personnelle : je reste moi-même, plus ou moins riche. En revanche, le capital en biens publics est fondamentalement intrusif et dynamique. Il faut le produire et le reproduire en permanence, car c’est dans l’interaction avec le monde extérieur qu’il s’actualise. Si le capital économique ressemble à un stock de pétrole, le capital culturel s’apparente davantage à l’électricité, difficile à stocker et dont la production et la consommation sont souvent simultanées.

Cette dualité permet de comprendre pourquoi les groupes É>C émettent un message qui n’est pas spécialement « libéral » (par opposition à « étatiste »). Le monde des affaires est de plus en plus marqué par l’arrivée massive du capital culturel et spatial : l’économie créative suppose une culture puissante et ouverte tandis que les dirigeants des grandes entreprises sont devenus des salariés dotés d’une formation de haut niveau. La fongibilité entre les deux types de capitaux n’est pas nouvelle et le système français de formation offre une certaine visibilité à ce processus. En effet, après avoir, pendant la Révolution, supprimé les universités, les avoir remplacées par des écoles techniques puis avoir, un siècle plus tard, des universités faibles, incomplètes et dépendantes, la production intellectuelle des dirigeants s’est trouvée canalisée dans un petit nombre de filières très sélectives, fortement corporatistes et déconnectées de la recherche. Il existe en conséquence, avec l’École nationale d’administration (ENA) et les « grands corps », une filière quasi exclusive de construction du capital culturel spécifique à ceux qui veulent accéder au sommet du pouvoir économique et politique, ce qui leur permet de circuler librement d’un sous-secteur à l’autre tout au long de leur vie professionnelle. Même s’il s’agit plutôt de compositions faisant varier le capital économique et le capital politique (et non culturel), on comprend au moins comment le capital culturel, du moins dans son approximation scolaire, peut tendre à devenir une sorte d’équivalent général des capacités socialement valorisables. Corrélativement, si l’on descend d’un degré dans la hiérarchie des formations, la prolétarisation des universités, qui a accentué la coupure, perceptible aussi dans d’autres pays, mais à un moindre degré, entre capital économique et capital culturel, atteint des extrêmes en France, avec une méfiance réciproque entre le monde des « clercs » haïssant l’argent et le monde « de l’entreprise » méprisant les « intellos ».

Cependant, avec la perspective d’une valorisation, « en même temps », de tous les porteurs d’innovation, proposée par Emmanuel Macron mais depuis plus longtemps dans de nombreux autres pays européens (et même aux États-Unis dans le projet démocrate, de Roosevelt à Obama), les nouvelles synergies productives et le processus de réconciliation entre détenteurs de capitaux-biens privés et -biens publics se trouvent valorisés. Même si elle est contrariée par des logiques institutionnelles, la tendance vers un É=C se fait jour un peu partout. Elle passe par une ouverture permanente au changement personnel et la construction d’un équilibre psychique sans cesse renouvelé qui ne serait plus perçu par les intéressés comme une menace ou une défaite mais comme une condition de la stabilité du moi.

Qu’est-ce que le « changement » pour un individu ? Cela reste une question ouverte, en partie polluée par les injonctions à courte vue venant d’une partie du monde du travail et qui consistent à réduire la dynamique individuelle à une adaptabilité illimitée, pilotée de l’extérieur et sans bénéfice évident du point de vue de la personne concernée. Ce genre d’injonction s’accompagne de la valorisation du changement pour lui-même, indépendamment de la nature de ce changement. Le recours à des allégories darwiniennes glorifiant la nécessité de changer « pour survivre » complète le tableau de ces malentendus destinés à éviter des réticences ou des résistances fondées sur l’argument que tout changement n’est pas utile à la société ou bénéfique à ceux qui le subissent. Cette approche à la fois pauvre et instrumentale du changement psychique ne doit pas masquer l’homologie fondamentale entre construction de compétences à forte composante créative et la mise en mouvement de pans importants de sa propre personnalité. On ne peut pas construire des énoncés cognitifs novateurs qui supposent un minimum d’écart disruptif avec le mainstream institué sans affecter, cause et conséquence à la fois. Inventer quelque chose de significativement nouveau qui puisse, par ailleurs, être considéré par d’autres acteurs comme de quelque utilité pour la société ne peut se limiter à « bien faire son métier » ou à « être un bon artisan », même si ces qualités sont aussi partie prenante des processus créatifs. Au-delà des modes et des récupérations réductrices, les systèmes productifs ont de plus en plus besoin de personnes qui assument la porosité entre travail pour les autres et travail sur soi.

Inversement, les électorats des partis populistes se caractérisent par ce refus du changement de soi, qui, en Europe, est relié avec la défense d’un État-providence qui redistribue massivement des biens privés, qui se situe au niveau national et est perçu comme menacé par les changements d’échelle économiques et politiques. Ainsi peut-on comprendre l’alliance de ces deux attitudes dans le mouvement des Gilets jaunes comme dans l’électorat de Donald Trump : refus d’une dynamique sociétale qui exigerait une dynamique personnelle.

Comme ils refusent cette mise en mouvement, les membres de ces groupes, qui se sentent en voie de déclassement et ont le sentiment d’être abandonnés par les « élites », combinent dans leur rapport à la société un mal-être et une défiance généralisée (Marcus et al. 2019). Dans l’analyse de ces attitudes politiques, il devient inévitable d’aborder l’acteur politique individuel sous l’angle de son psychisme, conçu comme un ensemble qui comprend et articule des activités et des productions non réductibles les unes aux autres, le cognitif et l’affectif, d’une part, le subjectif et l’objectif, d’autre part. La psychologie politique a longtemps consisté à rechercher une part affective cachée et rétive aux choix rationnels ou à appliquer à des groupes, voire à des sociétés entières, des notions construites pour s’appliquer à des individus. Il s’agit ici d’autre chose : imaginer une psychopolitique en réussissant à dépasser les difficultés des différentes sciences du psychisme (psychologie expérimentale, psychanalyse, neurosciences), à construire efficacement les problématiques de l’individu contemporain.

Le renouvellement du domaine s’est fait depuis les années 1990, notamment par les travaux sur la reconnaissance (Taylor 1992) (Honneth 1992) (Fraser 2000). Ce concept est construit par opposition aux « rapports de classe » pour l’accès au capital économique. Ces auteurs reconnaissent que l’approche classique ne permet pas d’appréhender certaines attentes politiques et la reconnaissance regroupe l’ensemble de ce manque. Dans une autre perspective et sur d’autres objets d’étude, l’idée de réflexivité, portée dans les années 1990 par Ulrich Beck, Anthony Giddens et Scott Lash (1994) sous le nom de « modernisation réflexive », qui relit de manière non métaphysique le patrimoine des études sur la conscience et permet d’aborder des processus sociétaux, mais aussi individuels, de prises de recul substantielles sur sa propre existence, de penser celle-ci comme un enjeu de sa propre action, soumise certes à des contraintes, mais capable d’opérer des inflexions biographiques significatives. On peut interpréter ainsi la « révolution silencieuse » « post-matérialiste » que Ronald Inglehart (1977) a détecté dès les années 1970 et qu’il analyse depuis lors. Elle correspond à une mutation volontaire des modes de vie qui ne vient pas au départ d’organisations ou d’institutions mais qui se mesure par un changement des valeurs et des modes de vie portés par des individus bien dotés en capital culturel et spatial. Il s’agit dans les deux cas d’un processus typique de réflexivité.

Dans cette psychopolitique, l’espace compte. David Goodhart (2017) prétend que les citadins des grandes villes ne manifesteraient aucune identification aux lieux : ils seraient anywhere par opposition aux autres habitants, vivant dans les petites villes, les campagnes ou les bassins industriels en crise qui seraient, eux, somewhere.

Cette thèse se révèle hautement critiquable. Le fait de se rendre disponible à toutes sortes de mobilités, au propre (« mobilité spatiale ») ou au figuré (« mobilité sociale ») ne signifie pas une indifférence aux lieux que l’on habite. C’est même exactement le contraire car, dans un contexte où les « enracinements » ruraux traditionnels ont disparu, le mode d’habiter urbain-campagnard a certes à voir avec un retour nostalgique à un référentiel paysan, mais l’enracinement lui-même fait partie du mythe : les périurbains ne résident pas, sauf exception et souvent de très loin, là où vivaient leurs ancêtres paysans devenus ouvriers. Il s’agit le plus souvent d’un choix spatial générique : le lieu importe peu du moment qu’on trouve un point d’équilibre entre les dépenses de logement (prix du sol et prix de la maison), les dépenses de mobilité et les ressources monétaires disponibles, permettant que, au bout du compte, on dispose des attributs du mode de vie recherché. Au contraire, ce sont bien les habitants des centres urbains les plus riches en urbanité qui manifestent le plus d’attachement à des lieux singuliers. Sinon, comment expliquer que les paubos (« pauvres bohème ») dépensent jusqu’à 50 % de leur revenu pour payer leur loyer dans des quartiers où les prix fonciers sont très élevés ? Des études convergent (Haegel et Lévy 1997) (Lévy 2008) (Florida 2002) pour montrer, que, indépendamment de leurs revenus, les demandeurs d’habitat à forte urbanité chérissent leurs quartiers et leurs villes. Lorsqu’ils se déplacent synchroniquement (s’ils fréquentent à l’échelle de la vie quotidienne plusieurs lieux distincts) ou diachroniquement (s’ils déménagent), ces habitants recherchent des situations spatiales aussi stimulantes que celle qu’ils quittent et ils peuvent éventuellement y développer une identité spatiale forte ; cela ne signifiera pas pour autant qu’ils sont insensibles au changement géographique, mais que la curiosité et l’espoir de nouvelles expériences spatiales équilibrent jusqu’à un certain point, sans pour autant l’annuler, la mémoire positive du vécu précédent, tout en créant un fort désir de renouer, un jour, avec la ville que l’on quitte. On peut donc parler d’alteridentité – l’altérité devenant le matériau fondamental de la construction des identités. Ce n’est pas nouveau (toutes les identités se construisent ainsi, en fait), ce qui est inédit, c’est la conscience et la valorisation de ce phénomène par les individus qui le vivent et qui, en conséquence, s’emploient à le renforcer.

L’espace politique entre en scène dans le débat public en France.

Comment ces mutations de l’espace politique français ont-elles été perçues et traitées par la société française ? Dans l’ensemble, avec beaucoup d’intérêt. On peut dire que, pour l’essentiel, les médias généralistes grand public ont pris la mesure de trois enjeux : i. la carte électorale a changé, ii. elle mérite davantage attention que dans les décennies précédentes car elle n’est plus la trace de réalités anciennes en voie d’extinction, mais nous parle des transformations en cours dans la société ; iii. en abordant ces transformations par leur dimension spatiale, on se donne une chance plus importante de les comprendre.

Personnellement, depuis que, en 1992, j’ai signalé la nouveauté de la carte du vote sur le référendum de Maastricht et que, depuis 1997, j’ai montré la force de l’extrême droite dans le périurbain, j’ai été sollicité de manière croissante par ces médias, mais aussi par des organisations et des institutions qui agissent à l’interface de la recherche et du monde professionnel, ou par des organismes à visée culturelle, parfois aussi, bien sûr, par d’autres chercheurs et institutions universitaires. La réception de l’Atlas politique de la France (Lévy , Póvoas, Ogier et Fauchille 2017) et de la Théorie de la justice spatiale (Lévy, Fauchille et Póvoas 2018) a confirmé que l’intérêt pour la relation entre espace et politique s’est installé dans le débat public, tout particulièrement en France. Plusieurs auteurs productifs et inventifs tels qu’Hervé Le Bras, Emmanuel Todd ou Laurent Davezies ont intéressé un public élargi en évoquant relations entre espace et politique.

Cela se produit dans un contexte où, depuis des années, un « chercheur indépendant », Christophe Guilluy (2000) (2014) (2016), s’est employé, avec une réussite indéniable, à convaincre que la « France d’en bas » était abandonnée par la « France d’en haut », que ces deux morceaux de la société étaient aussi deux parties du territoire, les « métropoles », d’un côté, les « périphéries », de l’autre, et que c’est cette inégalité de traitement qui expliquait la révolte des oubliés, manifestée notamment par un soutien aux thèses du Front national. Dans les grands médias, les thèses de Guilluy sont devenues une référence par rapport à laquelle tout autre intervenant est censé se situer. Le mouvement d’intérêt croissant pour la géographie sur la scène publique a franchi une nouvelle étape, devenant un passage obligé de toute analyse électorale et même, de plus en plus, de tout examen des politiques publiques. Guilluy a construit un modèle explicatif tout à fait contestable, qui consiste à utiliser les différences de productivité de l’espace (notamment entre les métropoles prises comme un tout et le reste du territoire français) comme si elles rendaient compte des différences de statut des habitants : pour lui, puisque les métropoles sont riches, l’ensemble de leurs habitants aussi, même s’ils sont, apparemment, pauvres Cela apparaît particulièrement absurde (au point qu’on puisse douter de l’honnêteté intellectuelle de l’auteur) lorsque l’on sait que l’immense majorité des pauvres se trouvent en ville (centre et banlieue), tout spécialement dans les grandes villes, qui sont justement les plus productives.

Par ailleurs, Guilluy place dans la même catégorie le périurbain et les localisations extérieures aux grandes aires urbaines (hypo- et infra-urbain), alors que les zones périurbaines sont à la fois celles qui contiennent le moins de pauvres et qui donnent proportionnellement le plus de voix au Front national.

On peut donc dire que Guilluy accorde à l’espace une grande importance, comme s’il s’agissait d’une nouvelle théorie générale du social, mais en donnant à des métaphores soit verticales (en bas/en haut), soit horizontales (centre/périphérie) la place d’une analyse des réalités empiriques. Ce faisant, il cherche à légitimer, par une « expertise » fantaisiste, une idéologie qui lui préexiste dans une partie de la société. Cette démarche a été critiquée de manière convaincante – cf. notamment l’analyse de Stéphane Cordobes (2014) –, mais les réfutations restent cantonnées à la sphère universitaire. Ailleurs, beaucoup utilisent, sans forcément y adhérer, la matrice argumentative de Guilluy comme un point de départ obligé.

En résumé, la situation se caractérise par un intérêt réel de la sphère publique pour les mutations de l’espace politique, mais avec, parfois, une certaine naïveté que l’on peut comprendre comme le signe d’un certain manque de culture scientifique dans un domaine encore très nouveau pour la plupart des observateurs.

Les figures de la dénégation.

Face à ces questions, on rencontre aussi un réel intérêt dans le monde des chercheurs professionnels. Cependant, on peut identifier un ensemble de travaux qui s’emploient à démontrer qu’il ne s’est rien passé, ou pas grand-chose, que la place attribuée à l’espace par certaines études est trop importante et que, somme toute, les méthodes habituelles d’analyse du vote se révèlent toujours efficaces. Cet ensemble était constitué au départ de deux groupes disjoints, mais qui sont raccordés par la présence de thématiques et d’auteurs communs : celui, déjà ancien, d’une partie des chercheurs du courant de la « Géographie sociale » (avec notamment Fabrice Ripoll, Jean Rivière et Vincent Veschambre) et celui, plus récent, au sein de la revue Métropolitiques. Ces deux foyers contribuent à créer une mouvance antispatiale dans les sciences sociales. Le projet est paradoxal en ce que les chercheurs qui en font partie s’intéressent à l’espace, mais s’emploient à chaque fois à conclure que la dimension spatiale a été surestimée (par d’autres) et qu’il faut la remettre à sa (petite) place.

Dans les lignes qui suivent, j’ai pris l’exemple d’un essai récent (Gilli et al. 2017), signé par Frédéric Gilli, Bruno Jeanbart, Thierry Pech et Pierre Veltz, et publié par le think tank Terra Nova. Ce texte résume assez bien les logiques argumentatives de cette mouvance. C’est un texte développé, précis, argumenté, qui se prête au dialogue et à la réfutation, contrairement à beaucoup d’autres qui se contentent d’allusions ou de conclusions. En choisissant ce document, je n’ai pas voulu polariser ma critique sur les deux chercheurs du groupe [2], qui sont tout à fait estimables (Pierre Veltz a apporté beaucoup à la connaissance de la relation entre villes et mondialisation, Frédéric Gilli a fondé Métropolitiques, une revue originale centrée sur les relations entre ville et politique), pas plus que sur Terra Nova, un « laboratoire d’idées » qui contribue utilement au renouvellement des débats politiques en France. Je souhaite plutôt montrer que, même à ce niveau, on rencontre des points de faiblesse qui témoignent des difficultés ou des réticences à se laisser déranger par ce qui change. Et, pour inverser l’idée de Ludwig Wittgenstein, ce dont on peut parler, dans la proposition comme dans la critique, je pense qu’il faut le dire.

Voici trois figures qui illustrent les apories de la démarche critiquée plus haut.

1. Rideaux de fumée : raisonnements obliques.

Les auteurs du texte de Terra Nova ont choisi de ne pas s’affronter franchement à la force des différenciations spatiales et, pour réussir à les éviter, ils ont découpé l’espace de manière parfois étrange [3]. Dans l’ensemble, le lecteur s’attend à voir découper l’espace français selon un principe de partition (des sous-ensembles disjoints qui, à eux tous, constituent l’ensemble de référence, ici la France) alors que, en fait, on est en présence de morceaux construits de manière variée, se recouvrant partiellement et n’offrant pas, si on les réunit, de vision exhaustive. Ces imprécisions et cette hétérogénéité non justifiée des découpages donnent l’impression d’une faible maîtrise de la composante géographique de l’appareil statistique français. Ce ne serait pas surprenant de la part de journalistes qui, le plus souvent, n’ont pas reçu de formation dans ce domaine. Cela l’est davantage chez des chercheurs intéressés par la géographie. En tout cas, en présentant le périurbain comme extérieur aux aires urbaines, il est clair qu’on empêche toute analyse de la place du périurbain dans ces aires et plus généralement qu’on se prive du repère des gradients d’urbanité pour aider à la lecture des réalités émergentes, électorales ou autres.

On retrouve ces brouillages à propos de la cartographie. L’étude de Terra Nova consacre tout un chapitre aux « pièges du cartographisme », appelé aussi « géographisme ». Ils reprochent à certains, non cités, de ne retenir de l’explication du vote que sa géographie (p. 19), alors qu’il faudrait, disent-ils, inclure l’espace dans une approche plus complète. Au-delà des formules diplomatiques, tout le texte peut pourtant se résumer à l’idée que l’espace est secondaire et que, si on lui accorde de l’importance, on masque les logiques non géographiques, qui seraient, elles, plus fondamentales.

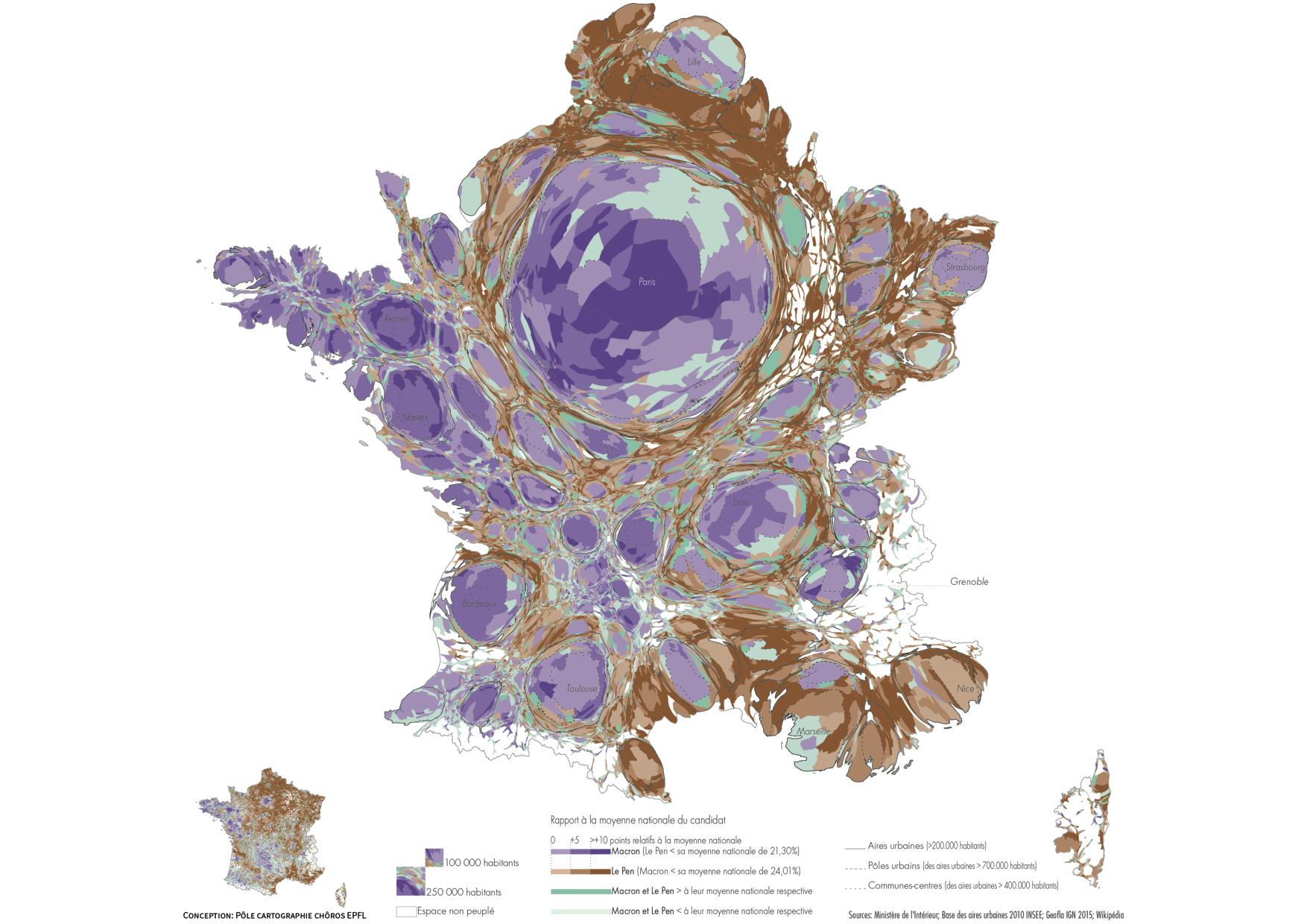

La carte euclidienne classique est critiquée (à juste raison) pour donner un poids disproportionné aux zones peu peuplées mais le cartogramme est lui aussi blâmé à travers l’exemple de deux cartes publiées par Slate.fr et l’Agence France Presse, qui montrent l’écart en points entre Macron et Le Pen au premier tour de la Présidentielle. « Ce type d’anamorphoses peut d’ailleurs inspirer des commentaires du type centre vs périphérie » (p. 15). Il est en fait reproché au cartogramme de montrer des choses qu’il ne faudrait pas montrer, et ce, indépendamment du fait que ces choses soient vraies ou non. Pourquoi ? Parce que « la focale cartographique tend à masquer d’autres déterminants, et notamment les déterminants socio-économiques et le niveau de qualification/diplôme » (p. 15). En quoi montrer quelque chose serait immanquablement « masquer » autre chose ? Les auteurs diraient-ils que la focale socio-économique tend à masquer d’autres déterminants, et notamment les logiques de localisation ? Pour eux, la différence de poids des couches populaires entre Paris et Marseille suffit à expliquer les différences de vote entre les deux centres-villes. Cette idée mérite attention, en effet, et il est vrai que le vote Mélenchon perturbe le duel Macron-Le Pen, comme le montre la carte suivante, publiée dans Le Monde après le premier tour de la Présidentielle – que les auteurs de Terra Nova ne commentent pas. Une partie des quartiers populaires marseillais et franciliens présentent une configuration politique qui rappelle celle du vote communiste dans les années 1970-1980.

Les lieux-Macron, les lieux-Le Pen et les autres au premier tour de la Présidentielle française de 2017. Source : Le Monde, 27 avril 2017.

Cependant, cela n’empêche pas que le théorème des gradients, énoncé plus haut, se vérifie dans la géographie du vote pour le couple Macron-Le Pen, telle qu’elle se manifeste dans l’aire urbaine de Marseille (qui comprend aussi un second centre, Aix-en-Provence), comme dans celle de Paris et ce, non seulement au premier tour, où ces deux candidats ne représentaient ensemble, à l’échelle nationale, que 16.4 millions de voix, mais aussi au second, qui en a mobilisé près de 32 millions. C’est bien justement ce qui caractérise cet événement : pour la première fois dans une élection généraliste, le type d’opposition qui domine, c’est celle qui correspond, géographiquement, au théorème des gradients.

Les auteurs auraient pu, pourtant, signaler que le cartogramme (s’il est construit avec des surfaces proportionnelles à la population) offre l’avantage de représenter les masses réelles, par son fond de carte, en même temps que les valeurs relatives, par les figurés du thème de la carte. Dans le cas de l’élection présidentielle française de 2017, par exemple, il est utile d’avoir en vue les quantités d’électeurs concernés, rendus sur la carte par les surfaces [4].

2. Casser le thermomètre : la statistique comme substitut à la description.

Un des malentendus de la critique que font les auteurs aux cartes électorales vient de ce qu’ils ne semblent pas comprendre ou admettre qu’une carte n’est pas plus une corrélation, au sens statistique de ce terme, que ne le serait un tableau présentant les mêmes résultats en rangeant les communes par ordre alphabétique. Il ne s’agit pas en effet de la comparaison entre deux distributions de variables indépendantes, mais d’une simple disposition des données, qui est le résultat de choix importants (fond de carte, classes, sémiologie graphique), mais d’un autre ordre que celui consistant à vouloir comparer les distributions de deux variables. En effet, la relation que le lecteur de la carte peut établir entre la configuration des proximités entre unités spatiales (jusqu’à quel point le lieu A est-il proche du lieu B ?) et les informations du thème (comment a-t-on voté dans le lieu A et le lieu B ?) reste ouverte et transparente. Au contraire, une corrélation statistique mesure de manière opaque et automatique la variance entre deux distributions dont rien ne nous dit qu’elles soient connectées par un lien causal direct ou indirect.

Or le plus souvent, le constat des actuelles dynamiques spatiales du politique est contesté par le texte de Terra Nova à partir d’exercices statistiques consistant en corrélations multiples, qui croisent vote, localisation et appartenance à une catégorie sociale. C’est une méthode qu’a souvent pratiquée Joël Gombin avec pertinence, lorsqu’il a montré que les corrélations vote/position sociale varient selon la distribution géographique : cela ne constitue pas une théorie ou un modèle explicatif, mais une invitation à aller explorer plus profondément.

Il s’agit alors bien de corrélations et non d’une relation directe du vote lui-même à un attribut de l’électeur, ce qu’on ne peut faire que par des sondages, qui sont menés en général à l’échelle nationale et permettent des tris croisés (qui ne sont pas non plus des corrélations). Or ces sondages montrent que, dans l’élection présidentielle de 2017, les oppositions les plus fortes dans les choix d’un candidat entre ouvriers et cadres sont du même ordre (de l’ordre de un à deux) que celles entre gradients d’urbanité à l’échelle nationale. En outre, dans le cas des différenciations spatiales exprimées par les cartes, il ne s’agit pas d’un sondage, mais d’une mesure exhaustive, qui ne comprend donc aucun biais statistique possible. Inversement, nombre d’interprétations fondées sur des corrélations proposées par le texte laissent béante la trappe de l’ecological fallacy (l’« illusion écologique »), en faisant comme si deux variables corrélées suffisaient à fabriquer un groupe dont chacun des membres possèderait les deux attributs. On sait depuis près de soixante-dix ans (Robinson 2009) que c’est une erreur. De fait, la covariance localisée d’ouvriers et d’électeurs de Jean-Luc Mélenchon ne prouve pas que ce sont les ouvriers qui votent Mélenchon, ce que confirment les sondages : malgré une bonne corrélation entre les deux variables, Mélenchon fait, en réalité, à peine mieux que sa moyenne chez les ouvriers et est nettement distancé par Marine Le Pen dans cette catégorie sociale [5].

3. Couvrez ce sein… Le politique, point aveugle.

« …que je ne saurais voir.

Par de pareils objets les âmes sont blessées,

et cela fait venir de coupables pensées. »

(Molière, Le tartuffe ou l’imposteur, III, 2).

« Les travaux de C. Guilluy se situent […] dans le prolongement des réflexions du géographe Jacques Lévy » (p. 4). Voilà une formule pour le moins surprenante, tant les deux démarches s’opposent, mais qui éclaire peut-être sur le projet du texte de Terra Nova. Ses auteurs affectent de s’opposer à Christophe Guilluy, un adversaire facile tant ses faiblesses argumentatives sont criantes, mais ils parlent en fait d’autre chose. Dans le texte, il est essentiellement question de géographie électorale, un domaine où les idées de Christophe Guilluy sont peu présentes. On peut donc penser que l’ensemble de ce texte vise plutôt les analyses proposées par d’autres chercheurs, qui se sont effectivement intéressés à la Présidentielle de 2017, parmi lesquels l’équipe qui a produit l’Atlas politique de la France (2017), pourtant non cité, ou d’autres textes que j’ai pu publier depuis 1992.

C’est d’autant plus surprenant que, au fond, Christophe Guilluy et les auteurs du texte analysé ici convergent pour proposer une explication au vote extérieure au politique. Métaphore chez Guilluy, l’espace devient ici bouc émissaire.

« Si la lecture géographique du vote fonctionne mal, c’est en partie parce que les fractures économiques et sociales qu’elle est censée organiser dans l’espace traversent en réalité la plupart des territoires, métropolitains ou non. […] Quelques vastes étendues, dans le Nord et l’Est principalement, sont globalement touchées par le déclin manufacturier et les effets dépressifs qu’il engendre. Mais la plupart des régions peu denses voient coexister des zones dynamiques et des zones déprimées. Bref, la géographie ne peut rendre compte des comportements électoraux qu’à la condition d’être étroitement combinée à d’autres grilles de lecture et pondérée par d’autres facteurs, dont les dimensions socio-économiques, mais sans doute aussi des effets d’histoire politique locale » (p. 12).

Ce que les auteurs rejettent, c’est qu’on puisse s’employer à expliquer un acte politique (le vote) au sein de la dimension politique du social, au sein d’un système politique ou d’une société politique qui sont entièrement partie prenante de la société dans son ensemble mais avec leurs enjeux, leurs dispositifs et leurs logiques propres. Admettre cela supposerait de reconnaître aux électeurs une compétence d’acteur politique, de citoyen. Or tout montre que les auteurs préfèrent se représenter ces électeurs comme des molécules sur lesquelles des réalités extérieures à la vie politique comme « la part de l’industrie » ou « le niveau des revenus » agiraient directement.

« En moyenne, une hausse locale de 1 000 dollars des importations par travailleur entraînerait une augmentation de 0,4 point de pourcentage de la part des votes en faveur de l’extrême droite entre deux élections » (p. 17).

[Il s’agit ici de la reprise des travaux de Clément Malgouyres (2017)].

Le recours à des corrélations aveugles permet d’éviter de poser le problème de fond : comment se construit le choix politique dans les républiques démocratiques contemporaines ? Une formule comme celle qui sert de sous-titre à la troisième partie du texte en dit long : « les critères qui ont pu peser sur le vote ». Comment des « critères » (c’est-à-dire des éléments informationnels définis par le chercheur pour caractériser les votants) peuvent-ils « peser » sur le vote, c’est-à-dire sur le choix des électeurs, qui agiraient donc, si l’on en croit les auteurs, sous la pression de leurs propres attributs, ce qui est logiquement bien étrange ?

Si on considère les quatorze communes gagnées par l’extrême droite aux dernières élections municipales (2014) : Beaucaire, Béziers, Bollène, Camaret-sur-Aigues, Cogolin, Fréjus, Hayange, Hénin-Beaumont, Le Luc, Le Pontet, Mantes-la-Ville, Marseille-7e secteur, Orange, Villers-Cotterêts, la liste parle d’elle-même. Il n’y a pas, c’est le moins qu’on puisse dire, de similitude dans la situation économique de ces lieux, et pas non plus de cohérence socio-économique des électeurs qui ont assuré la victoire. Les auteurs de l’étude et ceux qu’ils citent ne semblent pas accepter l’idée que le vote est un acte volontaire, réflexif et avant tout politique, qui n’est pas la conséquence mécanique de réalités d’autres natures, mais le résultat d’une intentionnalité propre, certes immergée dans un ensemble complexe de pratiques, d’idées et de choix, mais disposant de son autonomie. En attaquant la géographie, c’est le politique comme dimension sociale spécifique que les auteurs visent. Ils parlent aussi de « caractéristiques comportementales », se situant dans une démarche béhavioriste (les motivations profondes sont inaccessibles, contentons-nous de décrire les comportements), qu’ils ne cessent de mettre en œuvre dans l’ensemble du texte.

Une expression comme celle de « vote de classe » est présentée par divers auteurs – cf. parmi les publications récentes Desage et Haute (2017), ou encore Gombin (2017) – de la mouvance antispatiale, parfois pour en contester la réalité (c’est plutôt le cas dans le document de Terra Nova à propos du vote Macron), parfois aussi pour la valider, le vote Mélenchon apparaissant à certains comme l’heureuse surprise d’un « retour » du vote de classe.

Or, dans les deux cas, ils nomment « vote de classe » une corrélation géographique du vote avec une forte présence de certaines catégories sociales comme les cadres (représentant sans doute, pour les auteurs, la bourgeoisie) ou les ouvriers. En supposant que la corrélation ne soit pas trompeuse, cela ne suffirait pas à vérifier la pertinence du concept. Un « vote de classe » ne pourrait se déduire du seul fait que beaucoup d’ouvriers ou beaucoup de cadres votent de la même manière. Cela impliquerait que la notion de classe ne se limite pas au repérage de groupes socio-économiques (niveau de qualification et de revenu, type d’emploi) homogènes, mais revête un sens politique dans le cadre d’un affrontement entre modèles antagoniques de l’organisation de la société. Si on suit Marx, un vote de classe serait la conséquence d’une « conscience de classe », dont cette étude et d’autres qui utilisent l’expression ne disent rien. La notion marxienne de classe est reprise explicitement, mais en ne l’accompagnant d’aucune problématisation, comme si l’on pouvait se permettre de rejouer (sous forme de farce, cette fois ?) les mêmes notions, sans discussion ni générale, ni contextuelle. Au sortir de « tours » statistiques brouillons et fragiles, sortent du chapeau des concepts discutables et non discutés.

Quelques enjeux cognitifs.

Au-delà de l’enjeu direct (comment accepter ou non d’être dérangé par une réalité empirique nouvelle ?), on peut voir dans ces controverses l’expression de questionnements fondamentaux auxquels sont confrontés les sciences sociales

1. Agents ou acteurs ? Le premier enjeu porte sur la caractérisation de la société actuelle. S’agit-il d’une société structurelle-communautaire ou d’une société d’individus-acteurs ? À cette question, toutes les réponses, y compris les plus nuancées, sont, a priori, légitimes, du moment qu’on les étaie par des arguments.

Chez les « géographes sociaux » de la mouvance antispatiale, l’idée centrale est que l’espace n’est que la projection de réalités non spatiales, telles que les « classes sociales », et qu’il convient de rejeter comme « spatialiste » toute idée contraire, notamment celles qui confèrent une même portée explicative aux logiques spatiales et non spatiales. Dans le cas de Métropolitiques, il s’agit plutôt de contester un système explicatif trop rigide, d’insister sur les « nuances » et de critiquer les théories trop simples. Dans les deux cas, le message est le suivant : en dépit des apparences, y compris celle, reconnue par plusieurs auteurs de cette mouvance, de l’impossibilité d’associer simplement le vote Le Pen à un groupe socio-économique spécifique, le vote de classe est là et bien là. On se trouve face à un paradoxe : ceux qui défendent un structuralisme non spatial (« Géographie sociale ») et ceux qui craignent dans la dimension spatiale un nouveau paradigme écrasant (Métropolitiques), s’entendent pour promouvoir, in fine, le vieux structuralisme marxien : une mécanique intangible, fondée sur un principe dernier socio-économique, qui conduit à ne pas s’intéresser au vote comme à un acte politique volontaire. Certains se réfèrent aux travaux de Pierre Bourdieu, mais ils sont plus timides que lui dans la prise en compte du monde idéel. Ils n’explorent que très partiellement les attentes et les imaginaires des individus et des collectifs qu’ils étudient. À l’instar de Bourdieu, ils refusent de prendre au sérieux les compétences cognitives et l’intentionnalité stratégique des individus et quand s’expriment ces citoyens qui n’ont fait pas moins, en fort peu de temps, que de bouleverser et recomposer le paysage politique, ces auteurs ne voient en eux que des agents dominés par des structures indéboulonnables. Lorsqu’ils dénoncent l’excès de l’explication par l’espace, s’il y a une chose que ces auteurs ne voient pas, c’est le rôle des spatialités, de l’agir spatial des acteurs…

2. Facteurs ou dimensions ? Le second enjeu porte sur la manière dont on se représente les différentes composantes du monde social. Pour les auteurs du texte, tout ce qui est attribué au spatial est pris à l’économique. Ils n’imaginent pas que ces logiques puissent être pensées autrement que comme des « facteurs » indépendants. On peut au contraire considérer que le social gagne à être lu comme un ensemble de dimensions qui sont autant d’angles d’attaque, de grilles d’analyse, de logiques explicatives traversant l’ensemble du monde des humains. L’idée que les deux aspects, le spatial et l’économique (et d’autres), puissent se combiner comme deux indicateurs d’un phénomène complexe dont ces dimensions seraient des composantes n’est même pas envisagée par le texte de Terra Nova et, en général, par les contributions de la mouvance antispatiale : parler de la géographie du vote, c’est forcément, selon les auteurs, cacher d’autres « facteurs ».

Comme on l’avait vu dans les années 1960-70, lorsque l’« analyse factorielle » semblait pouvoir résoudre tous les problèmes en remplaçant les théories par des « régularités » constatées après-coup, sans effort, en mettant des variables non contrôlées dans la moulinette statistique, on retrouve ici le piège du positivisme. Au-delà de l’« illusion écologique » évoquée plus haut, la confusion, permanente dans le texte, entre variables (traitées comme causes) et indicateurs (indiquant quelque autre réalité ou processus qu’il faudrait d’abord chercher à identifier), ou entre corrélation et explication, n’est plus tenable, d’autant que nous disposons, en sciences sociales, de plusieurs décennies d’expérience en matière d’analyse statistique. Or ici, comme si l’on en était encore à la découverte de l’analyse multivariée, l’usage de la statistique constitue pour les auteurs un justificatif (comme on parle de pièces justificatives) d’une absence de discussion sur ce qui devrait pourtant se situer au cœur du débat. Le positivisme de la corrélation permet de ne pas se demander comment, dans les sociétés contemporaines, un choix politique et un choix d’habiter peuvent résonner ensemble.

3. Conservatisme théorique et/ou conservatisme idéologique ? Les dénégations de l’agir spatial des habitants-citoyens dénotent, au bout du compte, un rejet du caractère politique de cet agir. Un certain nombre de chercheurs craignent que la division de la société politique sur des bases géographiques constitue un danger pour la qualité du débat public. Ils semblent avoir en tête une vision structuraliste de l’espace qui permettrait de déduire une attitude politique d’un « milieu », c’est-à-dire d’un environnement prédéterminant le comportement de ceux qui s’y trouvent immergés. Mais ce dont il est question aujourd’hui est tout autre : c’est la question du lien, dans la tête des acteurs, entre choix électoral et choix de la localisation de son habitat. Ce genre de relation complexe n’est justement pas pensable dans une matrice structuraliste. En faisant mine de craindre qu’on remplace le structuralisme économique par un autre, qui serait spatial, ces auteurs font fausse route. Ils s’accrochent à une vision selon laquelle les individus sont réductibles à leur appartenance à un groupe socio-économique irréversible et transmissible et ne veulent pas voir les signaux, qui n’ont plus rien de faible, qui montrent que le monde a changé. Pourquoi ce refus ? Ici le conservatisme théorique (je m’accroche à une théorie pour éviter d’avoir à changer mes cadres de pensée) nourrit le conservatisme idéologique (je tiens à l’idée que l’opposition gauche/droite, fondée sur la place de la redistribution étatique et calée sur les « rapports de classe » est indépassable), et inversement.

On se trouve dans une situation décrite par Roger Pielke (2007) à propos des conflits d’opinion sur la nature. Lorsque dissensus scientifiques et politiques se rencontrent sur les mêmes objets, on peut s’attendre à ce que la relation au savoir et à la diffusion du savoir soit profondément biaisée, poussant les chercheurs à se muer en activistes, puisque leur succès dans la sphère publique leur fournira, par ricochet, des ressources pour faire valoir leur point de vue dans le monde académique. En conséquence, les scientifiques impliqués par ces injonctions contradictoires se retrouvent à la fois juge et partie et ne peuvent plus jouer leur rôle de médiateur (honest broker) entre leurs productions et la société. Ils deviennent, tout au contraire, un obstacle à contourner. C’est, sur un mode moins dramatique que sur les questions climatiques, ce qu’on observe ici.

Oculos habent et non videbunt.

L’irruption de nouveaux phénomènes pose des problèmes particuliers, et redoutables, à la production de connaissances. À partir des mutations des espaces électoraux, on peut proposer une discussion plus générale.

« Elles ont une bouche incapable de parler, des yeux incapables de voir, des oreilles incapables d’entendre, un nez incapable de sentir, des mains incapables de toucher, des pieds incapables de marcher. […] Ceux qui les fabriquent leur ressemblent » (Ancien Testament, Psaume 115, 5-8).

Elles, ce sont, dit le Psaume, les idoles « d’argent et d’or », « œuvres des mains de l’homme », que les peuples adorent, au lieu de Dieu. Dans les religions monothéistes fondées sur des textes censés avoir été écrits par Dieu lui-même, se pose sans cesse la question de savoir si l’on peut communiquer directement avec le divin par ces textes ou s’il faut un intermédiaire, seul capable d’interpréter correctement le message. Ce problème fut au cœur de la contestation protestante du rôle du clergé, de la scission entre chiisme et sunnisme et, dans le judaïsme, de la divergence entre karaïtes et rabbanites. Dans son opéra Moïse et Aaron (Moses und Aron, 1954), Arnold Schönberg aborde la question de l’intermédiation pédagogique, rendue à la fois nécessaire et périlleuse par les caractéristiques du public et les conditions de l’interaction communicationnelle.

Je voudrais poursuivre la discussion en me déplaçant du terrain de la transcendance vers celui de l’auto-organisation. Dans quelle mesure et jusqu’à quel point les individus ordinaires doivent-ils passer par des traducteurs pour accéder à des réalités empiriques qui se fabriquent sous leurs yeux et dont ils sont eux-mêmes les coproducteurs ? Le problème n’est pas trivial, car le statut des sciences dans les sociétés contemporaines découle de la reconnaissance que le bon sens ne suffit pas et qu’il est bien utile, au moins en complémentarité d’autres représentations du monde, d’accorder du crédit aux énoncés scientifiques et aux « intermédiaires » qui les produisent pour, au bout du compte, augmenter la prise de chacun sur le réel. Mais dans ce cas, que peut-on exiger des chercheurs pour qu’ils réussissent cette médiation ?

Dans sa Critique de la raison pure (1781-1787), Immanuel Kant montre à la fois la force d’une démarche fondée sur des hypothèses librement énoncées par le chercheur, puis vérifiées empiriquement, et l’impossibilité de produire des connaissances effectives si le « jugement synthétique a posteriori », c’est-à-dire la confirmation d’un énoncé par l’expérience, n’intervient pas. Kant conteste à la fois la possibilité que les concepts dérivent directement de l’expérience et qu’ils soient autosuffisants pour penser le monde empirique. De cette double impuissance, empiriste et dogmatique, découle une approche relationnelle qui consiste à assumer l’existence de deux univers, théorique et empirique, à la fois autonomes et connectés : le chercheur utilise son imagination déductive pour préfigurer des objets à analyser empiriquement, mais il ne peut le faire efficacement qu’en tirant partie, par des « schèmes », d’expériences empiriques, c’est-à-dire en s’exposant au foisonnement du monde des phénomènes. Si l’on fait fi de ce nécessaire va-et-vient, on se retrouve soit condamné à ne faire que mettre en scène ses sensations et ses expériences subjectives, soit coincé dans un système étanche, qui permet par exemple de démontrer l’existence de Dieu par l’existence du concept de Dieu (« argument ontologique ») ou à se réclamer d’une « psychologie rationnelle » permettant de prouver l’existence de l’âme et de l’explorer en récusant toute étude empirique du psychisme.

La science est une invention réglée qui se fait sous la menace permanente de la réfutabilité (falsifiability) empirique, ce que développe Karl Popper (2007) (2006). Une théorie qui reste vraie sans que jamais la rétroaction de l’empirie puisse en fixer les lacunes et les limites est l’antithèse même de cette démarche. La tension cohérence/pertinence n’est pas dépassable car elle se trouve au cœur du travail scientifique, et c’est d’abord aux chercheurs eux-mêmes qu’il appartient d’utiliser la raison de manière réflexive pour montrer les limites cognitives d’une raison qui tournerait en rond à l’intérieur d’elle-même. Toute la question, à laquelle Popper a consacré une grande partie de son œuvre, c’est la manière dont on peut construire des tests capables d’invalider une hypothèse sans se faire mystifier par les ruses du dogmatisme. Dans la science du social, une difficulté particulière provient de la dynamique des réalités étudiées. En effet, l’historicité y fait inévitablement vieillir les théories. On peut dire par exemple que les approches structuralistes pouvaient éventuellement réussir à passer quelques tests si on les confrontait à des sociétés à principe communautaire encore très présentes au 19e siècle, mais qu’elles échouent franchement si on les met en face du matériau empirique des sociétés d’individus contemporaines. Toutefois, le mouvement historique des sociétés ne procède pas par des basculements instantanés d’une situation claire à une autre situation claire, mais par des processus d’activation/inhibition souvent lents et discrets, qui rendent possibles des états de transformation partielle faits de cohabitations ou d’hybridations. Il en résulte que l’identification d’un phénomène nouveau doit tout particulièrement affronter les « idoles » qui ont des yeux mais ne peuvent ou ne veulent pas voir le changement.

Le raisonnement de Popper, selon lequel il ne suffit pas de citer une avalanche de faits à l’appui d’une théorie pour la rendre irréfutable (l’abondance d’observations de cygnes blancs ne rend pas solide l’affirmation selon laquelle tous les cygnes seraient blancs), s’en trouve conforté. La prise en compte des dynamiques sociales conduit à accorder beaucoup d’attention aux phénomènes émergents encore peu massifs, voire demeurant à l’état de virtualité (« signaux faibles »).

C’est dire que ceux qui ne veulent pas laisser leur théorie se faire déranger par l’empirie disposent ainsi d’une ressource supplémentaire. À l’hypothèse ad-hoc consistant à installer dans la théorie un cookie anti-test – ce que reproche Popper à la psychanalyse lorsqu’elle interprète aussi bien le refus que l’acceptation par le patient de l’existence d’un inconscient comme une confirmation de la théorie freudienne –, s’ajoute une arme de choix pour ceux qui prétendent que le monde est immobile : la présentation de phénomènes apparemment nouveaux, mais qui confirment au bout du compte qu’en fait, rien n’a changé.

Un auteur comme Emmanuel Todd ne cesse d’utiliser comme critère de classification des espaces contemporains la présence plus ou moins forte de « familles complexes » (ménages comprenant trois générations), sachant que la prévalence maximale de ce type de familles ne dépassait nulle part 2 % en France dans les années 1970 et qu’il a pratiquement disparu aujourd’hui. Todd continue pourtant à en faire de cette réalité fantomatique un élément « matriciel » de ses théories sociales. Il a théorisé ce dispositif argumentatif à travers la notion de « catholicisme zombie » : même lorsqu’il n’y a plus de catholiques, il y en a toujours. Et il a encore enrichi son arsenal après les manifestations antiterroristes du 11 janvier 2015 (Todd 2015). L’esprit de cet événement est, dit-il, anti-égalitaire, bien que le Bassin parisien se caractérise depuis longtemps par la dominante de la famille égalitaire (un critère qui lui tient à cœur), qu’il associe au recul de la religion catholique. Comment est-ce possible ? Les Franciliens ne sont plus très catholiques depuis longtemps et l’hypothèse du « catholicisme zombie » ne peut pas vraiment, reconnaît-il, fonctionner dans ce cas. L’explication retenue par Todd est… qu’il y a beaucoup de cadres supérieurs à Paris. Face à l’incapacité de son modèle à expliquer le présent, il change brusquement de référence et adopte un autre structuralisme que celui qui fonde son anthropologie, celui, cette fois, d’une sociologie économique marxiste « adaptée », pour énoncer que ces nouveaux « bourgeois » sont forcément hostiles à l’égalité. Il illustre le fait que, lorsque l’on refuse par principe d’imaginer que le monde social puisse changer, on dispose d’un stock très fourni de modèles explicatifs qui ont eu autrefois une part de pertinence et dont il est toujours facile de prétendre qu’il en reste quelque chose.

On peut noter à cet égard que les théories qui prétendent le changement impossible possèdent un avantage auprès des chercheurs soucieux de ne pas à faire évoluer leur point de vue, puisqu’elles leur garantissent que, quoi qu’il arrive dans le monde, ils pourront toujours rester au chaud dans un cadre intellectuel immuable.

En résumé, la connaissance scientifique progresse dans une dialogique jamais jouée d’avance entre cohérence et pertinence. Comment trouver le bon geste stratégique entre un simple ajustement à la marge, permettant l’inclusion de nouveaux phénomènes dans un schème interprétatif inchangé (assimilation), et la recherche d’une nouvelle cohérence au prix d’un remaniement théorique significatif (accommodation) ? Les changements récents de la géographie électorale offrent à cet égard un terrain d’expérience stimulant.

L’irruption du nouveau comme conflit asymétrique.

Peut-on tirer de ce moment argumentatif des indications sur l’attitude à adopter lorsque des réalités empiriques inédites semblent émerger ? L’éthique de la recherche est clairement centrée sur la vérité, ici sur une approche élémentaire de la vérité, puisqu’il s’agit de faire valoir une factualité face à diverses attitudes de dénégation.

Dans ce genre de circonstances, on a affaire à un plan de débat dissymétrique. En effet, on se trouve face à un phénomène nouveau, qui surprend ceux qui le signalent tout autant que les autres et qui pourrait être rendu indiscutable par la seule mesure au moyen d’outils simples et reconnus par tous. Pourtant, le débat intellectuel se présente d’emblée comme une querelle interprétative. Comme si la simple attestation de ces événements inédits valait déjà prise de position. C’est une situation inquiétante qui renvoie à un biais courant en sciences sociales, mais aussi, plus souvent qu’on ne le pense, en sciences de la nature : si les événements nous dérangent, annexons-les à une théorie qui sera elle-même invalidée par des arguments idéologiques. Les faits que vous alléguez ne peuvent pas exister car, si c’était le cas, cela justifierait une thèse qui est politiquement inadmissible. Cette volonté de censurer, de l’extérieur, le travail scientifique, nommée parfois, par antiphrase, « pensée critique », fait débat sur la scène intellectuelle francophone d’aujourd’hui. On retrouve ici un problème classique dans l’ensemble des activités créatives, sciences et arts. Toute institutionnalisation de l’innovation contient un oxymore, et les institutions que sont les disciplines ou les courants de pensée indurés se battent bec et ongles contre tout ce qui remettrait en cause leur pouvoir de reproduction.

Bonne nouvelle : la dimension spatiale est entrée de plain-pied dans le débat public. Une culture de l’espace et de la spatialité se construit par tâtonnements sur la scène publique et parmi les citoyens.

Mauvaise nouvelle : il subsiste des réticences dans le monde de la recherche à intégrer les changements en cours. À nous de faire qu’il en soit autrement.

Modification apportée le 17 janvier 2020 : la présentation des équations (1) et (2) a été modifiée par l’auteur.