Le climat redevient un objet géopolitique avec le « réchauffement planétaire » : de nombreux articles ou ouvrages postérieurs aux années 1980 l’attestent. L’étonnant, dans cette manière de voir est cependant qu’elle n’est guère nouvelle. D’un siècle à l’autre, tout a été expliqué par le climat : la diversité des hommes, celle des paysages, des civilisations, la marche de l’histoire depuis les migrations jusqu’aux révoltes, etc. Un lien fort existe, dans de nombreuses sociétés, entre ceux qui « comprenaient le climat » et ceux qui possédaient le pouvoir. En témoignent les religions où les dieux, situés dans le ciel, parlent aux hommes par les désordres du climat (mythe du déluge, foudre) et où des sorciers, prêtres, sauveurs intercèdent pour les humains auprès des divinités célestes. Toutes les civilisations ont eu leur grande inondation et attendent leurs cavaliers de l’Apocalypse. Ces croyances sont plus proches de nous qu’on ne l’imagine puisque par exemple une loi anglaise de 1677 condamnait encore au bûcher les météorologues, taxés de sorcellerie. Le passage à l’an 2000 a même réveillé des peurs, des menaces terrestres et célestes que l’on pensait oubliées.

Le climat redevient un objet géopolitique avec le « réchauffement planétaire » : de nombreux articles ou ouvrages postérieurs aux années 1980 l’attestent. L’étonnant, dans cette manière de voir est cependant qu’elle n’est guère nouvelle. D’un siècle à l’autre, tout a été expliqué par le climat : la diversité des hommes, celle des paysages, des civilisations, la marche de l’histoire depuis les migrations jusqu’aux révoltes, etc. Un lien fort existe, dans de nombreuses sociétés, entre ceux qui « comprenaient le climat » et ceux qui possédaient le pouvoir. En témoignent les religions où les dieux, situés dans le ciel, parlent aux hommes par les désordres du climat (mythe du déluge, foudre) et où des sorciers, prêtres, sauveurs intercèdent pour les humains auprès des divinités célestes. Toutes les civilisations ont eu leur grande inondation et attendent leurs cavaliers de l’Apocalypse. Ces croyances sont plus proches de nous qu’on ne l’imagine puisque par exemple une loi anglaise de 1677 condamnait encore au bûcher les météorologues, taxés de sorcellerie. Le passage à l’an 2000 a même réveillé des peurs, des menaces terrestres et célestes que l’on pensait oubliées.

Ce recours aux dieux du ciel, aux astres lointains s’enracine dans l’imaginaire. Or, à la différence du temps qui est perçu, le climat est une abstraction. En conséquence, le regard porté par une société sur son (le) climat s’inscrit dans une vision d’ensemble de valeurs collectives. Il est envisagé comme stable ou comme changeant selon que prévaut l’idée que l’on se fait du mouvement, de la dynamique. Quant à la place de l’homme face au climat, elle se veut soit celle du spectateur, et donc de la victime, soit celle de l’acteur pour le meilleur (réduire les émissions de gaz à effet de serre) et pour le pire (perturber gravement le système planétaire).

Afin de mieux comprendre l’approche actuelle du climat « planétaire », en « changement », il convient de faire un peu d’histoire, de revenir sur la période de la Révolution industrielle. Pourquoi ? Parce que, selon une certaine vision du réchauffement climatique, l’usine, la locomotive et le bateau à vapeur seraient la cause du réchauffement contemporain, puisque la hausse thermique mondiale débute vers 1850 et qu’elle est attribuée à la combustion des énergies fossiles qui dégagent un résidu : le co2. Or, c’est à la même époque, au milieu du 19e siècle qu’est mis en place le réseau météorologique. Il fournit les seules données mesurées utilisées pour l’étude du climat, puisque antérieurement elles sont reconstituées. Cette période de Révolution, en Europe, dans un contexte d’industrialisation et donc d’urbanisation des territoires, s’accompagne, chez les élites, d’une idée de la science positive, du progrès continu, de la croissance recherchée, de l’entreprise conquérante. Ce modèle a fortement influencé la conception du temps météorologique et du climat, d’autant qu’à partir des Lumières, la sensibilité à la Nature change, cette dernière devenant largement idéalisée.

Faire du climat un objet de science grâce à des mesures fiables.

Lorsqu’en 1854, Urbain Le Verrier crée le réseau météorologique national, il est à la recherche d’un réseau fiable de mesures et fait table rase du passé.

Lorsqu’en 1854, Urbain Le Verrier crée le réseau météorologique national, il est à la recherche d’un réseau fiable de mesures et fait table rase du passé.

Pourtant, dès le 18e siècle, avec la vulgarisation du thermomètre et du baromètre, de riches propriétaires terriens, des rentiers, des érudits faisaient régulièrement des mesures météorologiques. Ils en tiraient des conclusions « savantes » sur le lien entre le corps humain et le temps, entre la production agricole et les caractères des saisons ou les excès météorologiques. C’est la société royale de médecine qui a été le plus loin dans l’organisation des relevés quotidiens après que Vicq d’Azyr eut fait mener une enquête sur l’origine de l’épidémie de la peste bovine qui a touché la France en 1775. Cent cinquante 150 médecins ont pratiqué trois fois par jour, pendant dix ans au moins, des relevés avec les méthodes mises au point par l’abbé Cotte. Cependant, faute de temps et de méthode d’analyse, aucune synthèse ne sera effectuée et peu à peu au 19e siècle la médecine minimise la part des facteurs climatiques dans la cause des maladies. Mais les « Histoires du Temps » d’érudits passionnés continuent de s’écrire alors que le réseau de stations s’installe au plus loin du savoir vernaculaire.

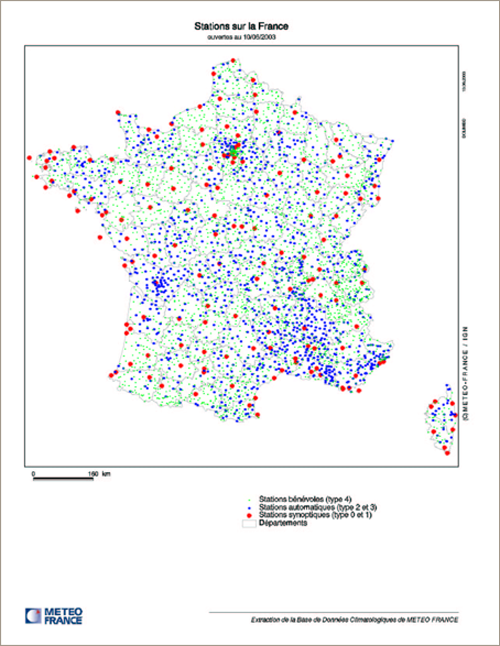

Treize villes reliées au télégraphe vont accueillir les premières stations météorologiques. Elles ont pour nom : Abbeville, Avignon, Bayonne, Besançon, Dunkerque, Chalons sur Marne, Le Havre, Lyon, Limoges, Mulhouse, Montauban, Mézières, Strasbourg, en plus de Paris. La rapidité dans la transmission des informations est ainsi privilégiée. Le réseau se densifie ensuite. Il s’internationalise après le premier Congrès météorologique international réuni à Vienne en 1873 qui crée l’Organisation météorologique internationale (devenu Office météorologique mondial). L’ensemble compte 10 932 stations en 2000, mal réparties sur les continents : l’Afrique est celui où elles sont les moins nombreuses. En 2005, la France compte 140 stations principales appartenant à Météo France.

L’organisation internationale a défini les normes des mesures. La station est un enclos gazonné où les appareils sont disposés à une distance des obstacles environnants (arbres, murets, maisons, etc.) égale à quatre fois leur hauteur. Il s’agit de s’extraire de la « réalité » des lieux et de leur diversité (bois, campagnes bocagères, champs, villages, villes). La température est toujours mesurée à l’ombre avec un thermomètre situé dans un abri tourné vers le pôle. Tous les équipements sont de même marque et les relevés sont effectués à heure fixe trois fois par jour avec report des mesures sur un bulletin pré-composé. La standardisation s’affranchit donc de la complexité des territoires. Mais alors comment par exemple appréhender le climat urbain avec de telles contraintes ? Et le climat au-dessus des océans ? L’objectif est de travailler avec des données comparables quel que soit le lieu de leur mesure. Pourtant, en un siècle et demi, l’étalement urbain va grignoter sur les campagnes. Si bien que les plus anciennes stations de mesure « hors les murs » se retrouvent aujourd’hui au cœur des agglomérations (Montsouris par exemple pour Paris), donc dans l’îlot de chaleur urbain que le périmètre normatif ne peut compenser.

Le modèle de station météorologique permet de mesurer un climat « virtuel » au sol ; il le devient encore plus avec les mesures en altitude. L’atmosphère a une épaisseur de plusieurs kilomètres que l’on ne peut observer à terre. Les radiosondages vont permettre de conquérir la troisième dimension à la fin du 19e siècle avec les ballons de Teysserenc de Bort, puis, au 20e siècle, avec les émetteurs embarqués d’Idrac et Bureau. Le volume d’atmosphère de l’ordre d’une dizaine de milliards de km3 d’atmosphère peut être ainsi analysé.

Pour mesurer les paramètres du temps, Le Verrier choisit d’utiliser un personnel peu qualifié, puisque les tâches sont répétitives, mécaniques et requièrent peu de (aucune ?) réflexion. Camille Flammarion décrit ce travail ainsi : « Le parfait service militaire, l’exécution ponctuelle de la consigne administrative » (Mémoires biographiques et philosophiques d’un astronome, 1911, p. 155). Ce choix s’explique par le souhait de mettre à l’écart toute personne ayant une idée sur le climat. Mais les « centurions de base » sont trop peu nombreux eu égard aux besoins pour la prévision. Aussi le réseau utilise-t-il des « bénévoles ». Au début, dans les écoles normales, les directeurs choisiront les volontaires au sein des élèves. Mais les contrôles « permanents » et les blâmes pour travail mal fait conduisent à chercher ce « petit personnel » ailleurs. Aujourd’hui encore, trois mille « bénévoles » mesurent pour Météo France températures et précipitations. Parmi eux, nombre d’agriculteurs, de météophiles très divers qui transmettent leurs données brutes au service départemental, mais font pour eux-mêmes et eux seulement, un travail climatique à partir de leurs mesures !

Des serviteurs dévoués au bas de l’échelle hiérarchique et au sommet des ingénieurs : en cela la structure du service météorologique copie l’usine. Deux grandes écoles vont fournir les « têtes pensantes » : l’école polytechnique dont est issu Urbain Le Verrier et l’École normale supérieure où ce dernier va chercher les physiciens et mathématiciens dont il a besoin. Ce n’est qu’en 1948 que sera créée l’École de la météorologie, qui occupera les locaux de la prestigieuse école française d’officiers de l’armée de terre de Saint-Cyr avant de partir pour Toulouse.

Quant au directeur des services météorologiques, il est nommé par le gouvernement. Ainsi Le Verrier nommé par Napoléon iii sera démis par lui en 1870 puis renommé au même poste par À. Thiers en 1873. Aujourd’hui, Météo France, établissement public administratif sous tutelle du ministère de l’écologie, du développement et de l’aménagement durables, est dirigé par le ministre de tutelle et un vice-président nommé par le conseil des ministres. Cette fonction échoue donc à des « grands serviteurs de l’État ». J. P. Beysson quitte par exemple ce poste pour un cabinet ministériel en 2004 et son successeur, P. E. Bisch, énarque, y arrive après avoir exercé comme préfet, puis entre autres comme conseiller au cabinet du premier ministre J. P. Raffarin. Cette porosité entre le scientifique et le politique n’est pas nouvelle puisque la météorologie a été une arme de défense nationale. Rappelons que c’est la destruction de quarante navires français et anglais par une tempête en Crimée en 1854 qui accélèrera la création du réseau. Après la Marine, la prévision se mettra au service de l’aviation militaire. Pendant le premier conflit mondial, les cartes journalières sont vides sur la « zone » du conflit, pour ne pas fournir d’informations à l’ennemi. À partir de 1918, l’aviation civile sera le principal utilisateur des informations météorologiques, d’où le fait que jusqu’en 1993, Météo France dépendait du ministère des transports. Le prix Nobel de la paix, attribué en 2007 à Al Gore et au Giec (Groupe intergouvernemental sur l’évolution du climat créé en 1988, Ipcc en anglais) ne fait que rappeler la pérennité de ce lien entre le politique et les spécialistes des sciences de l’atmosphère.

La création des services météorologiques nationaux a répondu au souhait de séparer le savoir scientifique sur le climat du savoir empirique, de la « sorcellerie ». Elle a conduit à former son propre personnel autant que possible. La nécessité d’échanges d’informations a contraint à « tout standardiser», tout contrôler : de l’installation des stations a-territorialisées, à la production de données, puis à leur traitement et leur utilisation, en créant ainsi un véritable monopole.

Faire du climat un objet virtuel par les statistiques pour les modèles.

La « science nouvelle » du 19e siècle est une connaissance construite sur des principes évidents, démontrables ou expérimentables. Quels que soient les domaines d’application, les méthodes employées pour obtenir le savoir sont identiques.

Le souci d’éliminer progressivement le subjectif en science conduit les ingénieurs à automatiser, à « libérer » l’homme de la tâche répétitive de la mesure. Peu à peu les appareils enregistreurs vont donc remplacer l’œil humain. D’abord par le stylet, lorsque sont utilisés les premiers thermographes à enrouleur Richard dès la décennie 1880. Ensuite avec les inventions militaires reconverties pour la météo : le radar dont le premier exemplaire est installé en France dans les années 1930 sur la ligne Maginot et qui entrera en service pour l’atmosphère en 1949 ; enfin le satellite : le premier est russe en 1957 et trois ans plus tard, le satellite météo Tiros 1 financé par le département américain de la défense, est lancé… Ils « photographient l’invisible » à des échelles hors de proportion avec la vision humaine. Pas étonnant donc que l’objet de plus en plus abstrait du climat passe progressivement de local et synoptique à planétaire et que la recherche sur le climat de la Terre se réduise souvent à un système atmosphère/océan, à un géoïde parfait en quelque sorte, sans sociétés humaines…

Le nombre est devenu le descripteur unique de la réalité. C’est sous Le Directoire qu’est créé un département des statistiques modernisé au milieu du 19e siècle en un Bureau de statistique générale, puis en Statistique générale de la France (Sgf), ancêtre de l’Insee. L’intérêt pragmatique du « chiffre » est évident puisque les mathématiques permettent de le traiter. Il est possible de compter, calculer, déchiffrer, dénombrer, estimer… grâce au calcul statistique et aux probabilités qui après Pascal et Fermat, se perfectionnent au 18e siècle avec les frères Bernoulli et leur loi des grands nombres, avec Condorcet, etc. Pour la météorologie, ce sont les Cassini puis Pierre Simon Laplace et Ramond, qui vont transformer les objectifs de la mesure en mettant en avant la comparativité de données enregistrées dans des conditions dissemblables. On doit à ces derniers, d’avoir imaginé de ramener des grandeurs à ce qu’elles seraient en gommant le relief terrestre. Des calculs de correction vont permettre de définir des pressions et des températures « ramenées au niveau de la mer ». La statistique va donner des méthodes pour « harmoniser » des séries de données. Dans l’affaire Mathieu de la Drôme, Le Verrier avouera que sous son prédécesseur (Arago) au Service des probabilités, car tel est le nom du service météorologique, on falsifiait les données. De même pour prévoir le temps du lendemain, compte tenu du peu d’information en mer, on pratique « l’assimilation ». Complexes à manier, les méthodes statistiques semblent opaques aux néophytes et au service d’idées préconçues. Ne dit-on pas : « Les chiffres sont comme les gens. Si on les torture assez, on peut leur faire dire n’importe quoi » ou encore « Les chiffres ne mentent pas, ce sont les menteurs qui chiffrent ». Et Jancovici (conseiller énergie-climat de N. Hulot) peut dire à un journaliste du Monde : « en intégrant la hausse des prix, la croissance pourrait être positive quand bien même la ménagère verrait son pouvoir d’achat diminuer ! ». Autre exemple, en 2007, le Giec vient tout juste de reconnaître que des erreurs de calculs avaient laissé croire que 1990-99 était la décennie la plus chaude depuis le début des relevés, or c’est 1930-39, avec un maximum en 1934 !

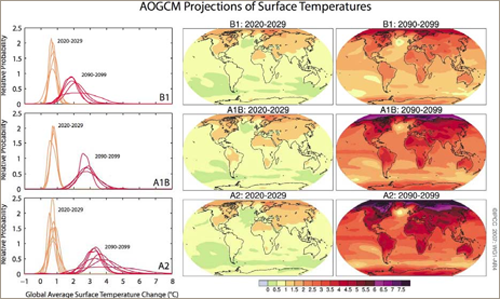

En 1954, un calculateur sera mis en service par les suédois. Et dans la décennie 1960, des modèles numériques, qui représentent l’atmosphère par un ensemble de lois physiques codées en langage informatique, vont permettre de calculer très vite des paramètres de sortie à partir d’un état initial défini par des paramètres d’entrée (des nombres). Ainsi sont calculées « rapidement des solutions approchées » (site Internet Météo France). Les modèles français d’échelle globale (Arpège, de résolution 35 km) ou d’échelle régionale (Aladin, 7 km) donnent la prévision du temps à huit heures à 90% de confiance, à deux jours à 80% mais au-delà ce n’est qu’une tendance suite au fameux « effet papillon ». Un battement d’aile sur Tokyo déclencherait un cyclone dans la Caraïbe ! Les modèles numériques initialement développés pour la prévision météorologiques sont utilisés pour la prédiction du climat. Ces modèles de climatologie, qui envisagent le climat en 2050 ou 2100, n’ont cessé de se complexifier ; aux données de l’atmosphère et de l’océan, se sont ajoutées les glaces de mer, les aérosols, la dynamique de la végétation. Des incertitudes subsistent toujours concernant le rôle des nuages, la renverse de certains courants océaniques, le rôle de variabilités cycliques comme l’Oscillation nord atlantique, ou acycliques comme l’El Niňo Southern Oscillation, etc. Enfin les modèles mixtes avec l’économie introduisent, entre autres, des variables démographiques et des taux de croissance, afin de simuler les émissions de gaz à effet de serre. C’est ainsi qu’ont été définis les quatre scénarios de B1 « vertueux » à A2 « tout croissance » concernant le changement climatique. La loi française a pris en compte ces scénarios et propose de diviser par quatre les émissions de gaz à effet de serre (« facteur 4 »). Tous ces modèles du futur remontent à la fin des Trente Glorieuses. Le Massachusetts Institut of Technology publie en 1970 Man’s impact on Global environment, qui remanié est repris en 1972 sous le nom de The Limits to Growth, ou rapport Meadows, commandité par le Club de Rome. Ce rapport prévoit pour l’avenir une pénurie de matières premières avant la fin du 20e siècle, une hausse insupportable de la pollution, la fin de la croissance et finalement l’effondrement inéluctable de l’écosystème mondial. C’est dans cet ouvrage que sera vulgarisée « la courbe de Keeling » montrant la hausse vertigineuse des teneurs en CO2 atmosphérique. Encore aujourd’hui, nombre d’alarmistes sur le climat revendiquent ce travail comme leur livre de chevet.

Faire du climat un objet de communication grâce aux images.

Au 19e siècle, les nouvelles élites urbaines pensent que la diffusion des idées est nécessaire à l’innovation industrielle. En cela elles perpétuent les idées des Encyclopédistes, voire de savants comme Arago qui avait ouvert aux journalistes les réunions de l’Académie des sciences. Des institutions scientifiques gratuites accessibles à tous se créent, comme le collège de France et les cours du Muséum d’Histoire Naturelle de Paris (devenu Muséum National d’Histoire Naturelle). C’est une période faste de croissance pour la presse destinée aux nouveaux bourgeois où écrivent de plus en plus de journalistes « scientifiques ». Quant à la science météorologique, elle y trouve vite une place. Son but prévisionnel implique le contact avec les professionnels des transports en particulier, via les médias, dans un rapport permanent avec la société et l’opinion publique.

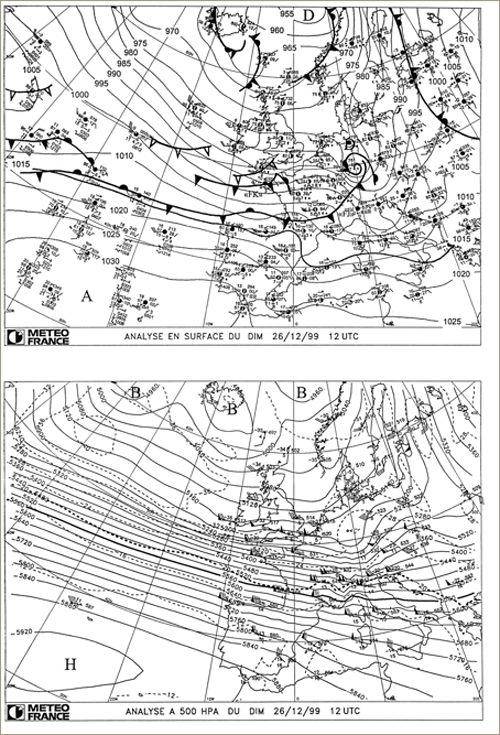

La cartographie occupe une place importante en météorologie et en climatologie. L’image cartographique permet une compréhension rapide. Elle représente l’espace et transcrit du ponctuel localisé en spatial à partir de choix qui dépendent du message à faire passer. L’idée en revient à Humboldt qui le premier a construit une carte d’isothermes afin de montrer les limites de croissance des espèces végétales. Dès 1863, Davy dresse des cartes avec des isobares et des flèches indiquant la direction du vent sur un fond Europe-Atlantique. Le souci de « voir venir les tempêtes » implique ce cadrage « synoptique » (qui donne une vue d’ensemble) et la représentation du temps réduite à la pression et à la direction du vent. Depuis septembre 1863, chaque jour est ainsi dessinée une carte synoptique.

à part les fronts qui ne seront dessinés qu’après la théorie de Bjerknes au début du 20e siècle, et la carte d’altitude (500 hPa), cette carte a peu changé. Elle utilise un langage universel (code international de transcription des observations) indépendant des langues ; en cela, c’est un modèle d’universalité qui explique son succès. Mais la carte synoptique a un statut particulier : entre le passé et le futur, et en tant que support de réflexion mais aussi de preuve a posteriori. En effet, longtemps la prévision à vingt-quatre heures a été effectuée par les prévisionnistes vers midi alors que toutes les données n’étaient pas encore parvenues. À la première carte de prévision (appelée Bulletin Quotidien de Renseignement) s’ajoutait une seconde carte réajustée après coup (le Bulletin Quotidien d’Étude). Ces deux cartes journalières ont été publiées jusqu’au Météo Hebdo.

L’usage de la cartographie est si « banal » que le Giec publie par exemple en 2007 des cartes planétaires du climat du futur (en 2020-29 ou 2090-99) réduites à la température moyenne ramenée au niveau de la mer et exprimée en anomalie par rapport à l’actuel.

Ces images à affect rétinien fort sont pourtant d’interprétation complexe. Les rapports présentent aussi des cartes d’anomalies de précipitation, à la fiabilité limitée car les résultats divergents selon les modèles en particulier entre les tropiques. Mais jamais aucune carte du champ de pression et des vents n’est montrée. Des indications chiffrées localisées sont beaucoup plus rares. Pour la première fois, en partenariat avec Météo France, Science et vie propose des températures, hiver après hiver, de 2050 à 2100. L’hiver 2094 sera le plus froid de la deuxième moitié de 21e siècle. Une telle précision laisse l’internaute pantois !

La carte est donc et surtout un moyen de communication vers le « grand public ». Des 1856 paraît dans le journal La Patrie un tableau des relevés météorologiques. Mais ils sont jugés austères par les lecteurs. Les premières cartes « prévisionnelles » de septembre 1863 sont envoyées à douze journaux parisiens et cinq en province ; pourtant ces derniers ne retiendront que le texte de prévision. C’est en 1876 que la première carte paraît dans Le Petit Journal.

Plutôt que le nombre et les mots, la carte apparaît aux journalistes comme un moyen de donner à voir à tous, de permettre une narration, de construire le discours sur le temps prévu le lendemain. Tous les journaux s’y mettent alors et cela… jusqu’à nos jours. Mais, seul « l’observatoire », la météorologie nationale transmet la prévision aux journaux. Les prévisions sont restées longtemps gratuites, lorsqu’en 2004, Météo France décide de rendre payantes les prévisions à trois jours. La levée de boucliers largement relayée par la presse a conduit Météo France à retirer son projet ; d’ailleurs, depuis cette date, de nombreux services sont payants. Météo France réalise autour de vingt millions d’euros de recettes en diffusant ses données. Son monopole est en passe de disparaître puisque certains quotidiens ont choisi d’autres fournisseurs (Le Monde) et que de nombreux sites Internet relaient une prévision gratuite (Met office, Allmet, chaines TV météo, etc.) et mettent en accès libre des banques de données (NOAA). Cette « affaire » a mis en lumière l’enjeu de l’accès aux gisements d’informations sur les territoires pour les particuliers et les professionnels.

Plutôt que le nombre et les mots, la carte apparaît aux journalistes comme un moyen de donner à voir à tous, de permettre une narration, de construire le discours sur le temps prévu le lendemain. Tous les journaux s’y mettent alors et cela… jusqu’à nos jours. Mais, seul « l’observatoire », la météorologie nationale transmet la prévision aux journaux. Les prévisions sont restées longtemps gratuites, lorsqu’en 2004, Météo France décide de rendre payantes les prévisions à trois jours. La levée de boucliers largement relayée par la presse a conduit Météo France à retirer son projet ; d’ailleurs, depuis cette date, de nombreux services sont payants. Météo France réalise autour de vingt millions d’euros de recettes en diffusant ses données. Son monopole est en passe de disparaître puisque certains quotidiens ont choisi d’autres fournisseurs (Le Monde) et que de nombreux sites Internet relaient une prévision gratuite (Met office, Allmet, chaines TV météo, etc.) et mettent en accès libre des banques de données (NOAA). Cette « affaire » a mis en lumière l’enjeu de l’accès aux gisements d’informations sur les territoires pour les particuliers et les professionnels.

Or, l’accès aux banques de données météorologiques avait déjà fait réagir les journalistes du quotidien Le Siècle en 1863. Mathieu de la Drôme avait fait appel à la presse parce que l’Académie des sciences ne voulait pas l’écouter sur ses méthodes de prévisions du temps et parce qu’il avait besoin de données supplémentaires pour affiner sa méthode. Mais, Le Verrier ne voulait pas lui fournir ses banques de mesures. Les journaux ont stigmatisé l’attitude des scientifiques… par la caricature faisant de la science, un mythe impénétrable. En même temps qu’il instrumentalise la presse, Mathieu est instrumentalisé par son éditeur Plon qui comprend rapidement que ces histoires sur le climat peuvent faire vendre. Il obtient ainsi les droits d’exclusivité concernant la publication d’un almanach, qui sera vendu à 100 000 exemplaires ! Les méthodes commerciales n’ont guère changé, puisque l’Express en publiant l’article intitulé « Les neiges du Kilimandjaro » (octobre 2006 relayé dans Le Monde), ne cherchait qu’à augmenter ses ventes. Les quotidiens, les hebdomadaires attirent le client avec des articles à titraille outrancière manipulant la peur. Vendre du climat enrichit toujours.

La météorologie a pour objet la prévision du temps des jours suivants : le temps ordinaire mais aussi et surtout celui qui compromet le bon fonctionnement d’une société (la « perturbation »). Elle porte donc particulièrement son attention sur les situations « à risques ». Elle se polarise sur les tempêtes, les grosses averses, les orages, etc. : l’événementiel en quelque sorte. La querelle Vaillant-Le Verrier au 19e siècle met en lumière cette difficulté entre prévoir et/ou mettre en alerte (éventuellement inutilement puisque des dépressions se forment en permanence sur l’Atlantique alors qu’elles ne deviennent pas toutes menaçantes pour le territoire). La difficulté va perdurer longtemps. Après les deux tempêtes de décembre 1999, Météo France va créer la carte de vigilance (pour les vents violents, les fortes précipitations, les orages, la neige et le verglas, les avalanches, la canicule) afin de répondre à ce besoin de clarification sur le « potentiel », tout en déresponsabilisant les services météorologiques face à l’imprévu (imprévisible ?). Les niveaux de fiabilité associés aux prévisions ont le même objectif.

La météorologie a pour objet la prévision du temps des jours suivants : le temps ordinaire mais aussi et surtout celui qui compromet le bon fonctionnement d’une société (la « perturbation »). Elle porte donc particulièrement son attention sur les situations « à risques ». Elle se polarise sur les tempêtes, les grosses averses, les orages, etc. : l’événementiel en quelque sorte. La querelle Vaillant-Le Verrier au 19e siècle met en lumière cette difficulté entre prévoir et/ou mettre en alerte (éventuellement inutilement puisque des dépressions se forment en permanence sur l’Atlantique alors qu’elles ne deviennent pas toutes menaçantes pour le territoire). La difficulté va perdurer longtemps. Après les deux tempêtes de décembre 1999, Météo France va créer la carte de vigilance (pour les vents violents, les fortes précipitations, les orages, la neige et le verglas, les avalanches, la canicule) afin de répondre à ce besoin de clarification sur le « potentiel », tout en déresponsabilisant les services météorologiques face à l’imprévu (imprévisible ?). Les niveaux de fiabilité associés aux prévisions ont le même objectif.

Cet angle d’attaque qui tient compte des enjeux explique pour partie qu’avec les nécessités de l’audimat télévisuel dans la décennie 1980, et donc l’utilisation de journalistes « vedettes » qui émaillaient leur narration d’histoires comme A. Gillot-Pétré (TF1, A2 et Libération) et de poésies comme M. Cardoze (TF1, TV Monte Carlo), la présentation de « la pluie et du beau temps » se soit popularisée, voire « peoplelisée ». Sont devenus la règle dans les médias : l’emphase (Le thermostat de la Terre sur maximum, titrait Le Monde), l’anthropomorphisme (Rita moins méchante que Katrina, Le Monde à propos des cyclones des Caraïbes) et bien sûr le catastrophisme utilisé par les éditeurs (et les auteurs) de livres récents sur le réchauffement récent (Le climat est-il devenu fou ? Terre, fin de partie ?). L’aboutissement de cette logique est le climat-slogan (« New deal environnemental »), le climat-spectacle dans les salles obscures (cf. Le film Une vérité qui dérange de D. Guggenheim sur Al Gore, qui sera couronné par un Oscar à Hollywood en 2006).

Les racines de la conception actuelle du climat « global » et de son changement sont en germe dans la météorologie naissante lors de la Révolution industrielle en Europe. Les méthodes choisies alors ont imposé une hiérarchie des disciplines scientifiques, une spécialisation croissante du savoir. Elles ont opéré le glissement du réel vers le virtuel, des échelles fines vers la planète, de la science en train de se faire vers une communication reposant sur une modélisation simpliste.

Après les Trente glorieuses, et surtout depuis les années 1980, l’écho du discours sur le changement climatique tend à une remise en cause des idéaux du 19e siècle en ne considérant plus que leurs revers : le « tout croissance », la démocratie sans participation, les progrès seulement technologiques. Le climat, tout comme l’environnement en général, est devenu un point d’ancrage de nouvelles valeurs supposées universelles, le catalyseur d’un espoir de nouvelle civilisation plus juste et plus responsable, une nouvelle utopie en quelque sorte, où le discours scientifique prend parfois des accents évangéliques.