« Si quelque chose est dit sur la nature, alors ce n’est déjà plus la nature. »

Ch’eng Hao (1032-1085)

Nous savons beaucoup et peu sur ce qui est désormais appelé par tous « changement climatique ». L’enjeu de cet événement est double : faut-il le classer dans l’« histoire naturelle » ou dans l’histoire de l’humanité ? faut-il se contenter de l’observer ou intervenir, et si oui, comment ? Ce cas, qui est plus qu’un exemple, permet de mieux comprendre en quoi les questions de nature se situent au cœur des enjeux de société.

Le réchauffement climatique : ce qu’on en sait et ce qu’on n’en sait pas.

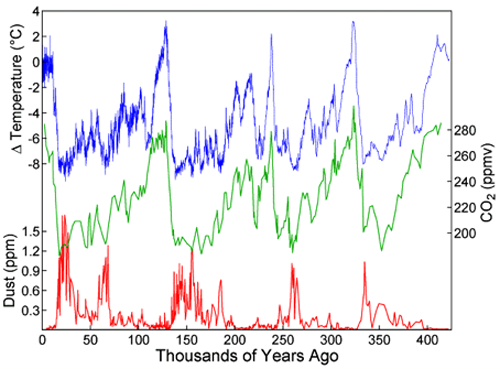

Ce que nous savons clairement à propos du réchauffement climatique est assez facile à résumer : l’émission de gaz à effet de serre (GES) a connu une croissance marquée depuis un siècle. Outre l’eau vaporisée, les principaux GES sont le dioxyde de carbone (CO2) l’ozone (O3) troposphérique, le protoxyde d’azote (NO2), le méthane (CH4) et les fluorocarbones chlorés (CFC). On a par ailleurs pu mesurer un réchauffement de 0,6ºC dans cette même période de la moyenne des températures. Le Giec (Groupe d’experts intergouvernemental sur l’évolution du climat ; en anglais : International Panel on Climate Change, IPCC), qui est un réseau de chercheurs créé et soutenu conointement par le Programme des Nations Unies pour  l’Environnement (PNUE) et l’Organisation Mondiale Météorologique (OMM) a joué un rôle important en favorisant et en rendant public l’accord de la majorité des climatologues sur un certain nombre de propositions concernant le changement climatique : Dans ses deux rapports, en 2001 confirmé en 2007 (Climate Change 2007. The IPCC 4th Assessment Report) le Giec note que la présence dans l’atmosphère de dioxyde de carbone (CO2) a augmenté d’environ un tiers depuis 1750. La concentration actuelle de CO2 n’avait encore jamais été atteinte au cours des 420 000 dernières années et probablement pas non plus au cours des 20 millions d’années précédentes. Le taux d’augmentation actuel est sans précédent depuis au moins 20 000 ans. Il est donc raisonnable de penser que l’action humaine est responsable du réchauffement. Les modèles de prévision qui prennent en compte cette cause ont été considérés comme empiriquement validés par une grande majorité des chercheurs, ce qui permet de parler d’un « consensus » scientifique sur le sujet. La prédiction de hausse des températures en surface pour la fin du xxie siècle présentée en 2007 se tient, selon les scénarios, dans une fourchette de +1,1-+6,4ºC par rapport à une moyenne de référence des années 1980-1999.

l’Environnement (PNUE) et l’Organisation Mondiale Météorologique (OMM) a joué un rôle important en favorisant et en rendant public l’accord de la majorité des climatologues sur un certain nombre de propositions concernant le changement climatique : Dans ses deux rapports, en 2001 confirmé en 2007 (Climate Change 2007. The IPCC 4th Assessment Report) le Giec note que la présence dans l’atmosphère de dioxyde de carbone (CO2) a augmenté d’environ un tiers depuis 1750. La concentration actuelle de CO2 n’avait encore jamais été atteinte au cours des 420 000 dernières années et probablement pas non plus au cours des 20 millions d’années précédentes. Le taux d’augmentation actuel est sans précédent depuis au moins 20 000 ans. Il est donc raisonnable de penser que l’action humaine est responsable du réchauffement. Les modèles de prévision qui prennent en compte cette cause ont été considérés comme empiriquement validés par une grande majorité des chercheurs, ce qui permet de parler d’un « consensus » scientifique sur le sujet. La prédiction de hausse des températures en surface pour la fin du xxie siècle présentée en 2007 se tient, selon les scénarios, dans une fourchette de +1,1-+6,4ºC par rapport à une moyenne de référence des années 1980-1999.

Ce qui apparaît comme un constat presque indiscutable est cependant aussi un objet complexe, à l’intersection de la science et de la politique. À la question « Que sait-on ? », s’ajoutent immédiatement d’autres : « Que croit-on savoir ? » et « Qu’en dit-on ? » et « Que veut-on ? ».

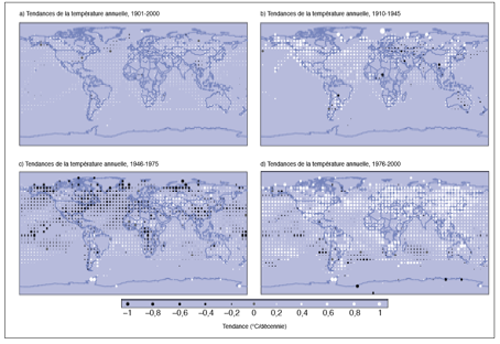

Le constat initial s’appuie sur des mesures effectuées depuis plus de cent ans. On peut d’abord examiner l’objection de l’urbanisation, dont l’impact sur les stations météorologiques aurait pu perturber les mesures en raisons des « îles de chaleur » produites par les espaces densément bâtis. Cet effet est jugé très faible par la majorité des chercheurs, même si la controverse n’est pas close sur ce point. Le troublant article de Vincent Gray (publié sur un site qui, il est vrai, rassemble de nombreux articles hostiles au modèle standard) montre un parallélisme étonnant entre la baisse du nombre de stations météorologiques (essentiellement dans les zones peu habitées) et l’augmentation des températures mesurées. Par ailleurs, une étude portant sur l’Espagne méditerranéenne (Quereda Sala et al.) conclut que, si l’on tient compte de l’effet de l’urbanisation sur les mesures, on ne peut exclure une stabilité des températures depuis 1940.

Si, néanmoins, on considère que le phénomène du réchauffement est établi à l’échelle planétaire, il existe cependant des zones de la planète dont la température a diminué. Par ailleurs, on comprend mal les distorsions entre les températures de l’océan et celles des continents, entre les températures au sol et celles qu’on mesure en altitude. Ce ne sont pas des détails car notre incapacité à transformer des mesures linéaires en explications systémiques jette le doute sur l’ensemble de la construction explicative. En fait, nous ne savons pas encore relier de manière satisfaisante les mouvements linéaires que nous mesurons à des dynamiques systémiques.

Fig. 1 : L’évolution des moyennes thermiques annuelles, 1901-2000.

Source : Rapport du Giec, figure TS3, p. 26.

Source : Rapport du Giec, figure TS3, p. 26.

[1] Une hypothèse crédible est que l’augmentation planétaire des températures à la fin du xixe siècle pourrait difficilement être attribuée à une activité industrielle encore balbutiante et confinée à l’Europe, mais plutôt à la sortie, pour des raisons non humaines, de la phase froide multiséculaire appelée Petit Âge Glaciaire (xve–xixe siècle).

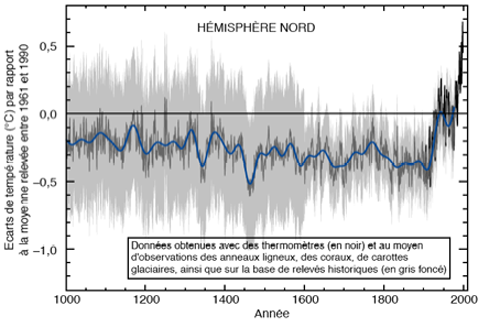

Ces débats, riches en controverses, contribuent en tout état de cause à rappeler que l’action humaine ne porte que sur une partie des processus impliqués dans la dynamique climatique. Il y a d’ailleurs eu un débat contradictoire au sujet de la simplification des variations climatiques avant l’histoire ou avant l’histoire récente, les courbes proposées par certains chercheurs (notamment celle de Mann, voir figure 5 et [Mann, Bradley & Hughes, 1998 ; Von Storch et al., 2004]) tendant à sous-estimer l’importance de changements qu’on ne peut en aucun cas attribuer aux hommes. Indépendamment de l’action humaine, l’effet de serre a pour effet, on le sait de générer un climat compatible avec l’écologie du monde vivant. Sans effet de serre, la température tomberait à –18ºC, ce qui provoquerait une glaciation, la réflexion des radiations solaires sur la calotte glaciaire recouvrant la planète la ferait encore descendre, à –100ºC environ. L’effet de serre n’est pas seulement produit par des gaz : la nébulosité, piège une partie de l’énergie de l’atmosphère. Cet effet spécifique des nuages est difficile à mesurer car il joue aussi en sens inverse, diminuant la pénétration des rayons solaires dans l’atmosphère. Quant à eux, les GES sont pour 55% composés de vapeur d’eau. En admettant que l’augmentation récente des émissions des GES est entièrement d’origine humaine, cet événement ne porte que sur les 45% restant, soit environ 15% de l’ensemble. Si on ajoute la composante indépendante de l’effet de serre liée à la variation de l’insolation, on peut considérer que l’action humaine ne concerne que moins de 10% des causes de changements observables à l’échelle de la décennie ou du siècle. Si maintenant on envisage des événements de plus grande portée (comme les glaciations du Quaternaire ou, plus encore, les grands changements qui ont marqué l’histoire de la Terre depuis son apparition), l’action contemporaine des hommes devient tout à fait négligeable.

Le rôle des hommes a peut-être, inversement, été sous-estimé. Une école de pensée, minoritaire parmi les climatologues, notamment représentée par William Ruddiman [2003], prétend, cependant, que d’autres phénomènes anthropiques engagés dès les débuts de l’agriculture, comme la déforestation (depuis 8 000 ans) ou la riziculture (depuis 5 000 ans), auraient pu avoir des effets significatifs sur le climat et auraient atténués des effets de cycle naturels. Pour cet auteur, la Peste Noire en diminuant la population et, par voie de conséquence, les zones cultivées, aurait au contraire conduit à une diminution des températures et contribué au Petit Âge Glaciaire.

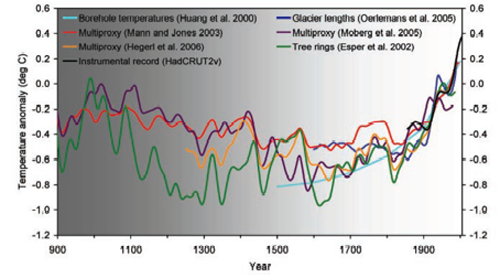

Nous ne savons pas encore articuler de manière satisfaisante temps courts et temps longs, en partie à cause de la qualité insuffisante des reconstructions de l’histoire climatique de la planète. Tous les chercheurs s’accordent néanmoins pour reconnaître que durant les dix derniers siècles des changements climatiques d’ampleur comparable à ceux auxquels nous assistons se sont produits. Les estimations divergent mais, selon certaines, il aurait fait à peu près aussi chaud qu’aujourd’hui aux alentours de l’an mille et un degré de moins durant les xiiie et xive siècle, d’une part, dans la première partie du xviie siècle, d’autre part, sans que l’action humaine semble avoir joué un rôle dans ces fluctuations.

Fig. 4 : Les températures depuis l’an mil, comparées à la moyenne 1961-1990.

Source : Rapport du GIEC, figure SPM 1b, p. 4.

Source : Rapport du GIEC, figure SPM 1b, p. 4.

Source : « Surface Temperatures Reconstruction for the Last 2,000 Years », figure S1, p. 2.

Source : « Surface Temperatures Reconstruction for the Last 2,000 Years », figure S1, p. 2.

Si l’on se place maintenant à des échelles temporelles très grandes, il est hors de doute que d’énormes transformations climatiques qui ont marqué l’histoire de la planète à différentes échelles de temps (du million au milliard d’années), liés à des facteurs géologiques ou astronomiques plus ou moins éclaircis, on sait, en gros, que la température moyenne de la Terre fluctue entre 10 et 25ºC depuis 600 millions d’années. Sans effet de serre, elle serait de –18ºC, avec un effet de serre maximal, de 30ºC. C’est entre ces bornes que se situe la problématique du changement climatique.

Or il n’est pas facile d’être affirmatif sur le décrochage du rythme d’évolution de la concentration du dioxyde d’azote dans la période récente. Les mesures par carottage dans les glaces de l’Antarctique (figure 6) semblent montrer qu’il existe des cycles d’ordre de grandeur de 100 000 ans avec lesquels les changements récents semblent compatibles. Il existe par ailleurs une multitude de modèles cycliques d’une durée allant de 22 ans à 225 000 ans, liés soit à l’activité solaire, soit aux variations de la position ou du mouvement de la Terre et l’on doit admettre qu’il est tout à fait imaginable que la combinaison de ces cycles suffirait à produire l’actuel réchauffement.

Fig. 6 : Estimation des variations climatiques depuis 400 000 ans.

Source : Petit J.R., Jouzel J., Raynaud D., Barkov N.I.,Barnola J.M., Basile I., Bender M., Chappellaz J., Davis J., Delaygue G., Delmotte M., Kotlyakov V.M., Legrand M., Lipenkov V., Lorius C., Pépin L., Ritz C., Saltzman E., Stievenard M. (1999). « Climate and Atmospheric History of the Past 420,000 years from the Vostok Ice Core, Antarctica ». Nature 399: 429-436.

Source : Petit J.R., Jouzel J., Raynaud D., Barkov N.I.,Barnola J.M., Basile I., Bender M., Chappellaz J., Davis J., Delaygue G., Delmotte M., Kotlyakov V.M., Legrand M., Lipenkov V., Lorius C., Pépin L., Ritz C., Saltzman E., Stievenard M. (1999). « Climate and Atmospheric History of the Past 420,000 years from the Vostok Ice Core, Antarctica ». Nature 399: 429-436.

Inversement, nous pouvons constater que des événements de faible importance à l’échelle de la planète comme l’éruption d’un volcan ou la chute d’une météorite peuvent avoir des effets non négligeables sur le climat et les écosystèmes – du moins dans leurs effets sur la vie humaine –, tant les « réglages » climatiques sont sensibles. L’explosion du Pinatubo, aux Philippines, en 1991 a ainsi créé la plus grande catastrophe écologique mesurée avec des instruments fiables : celle-ci se caractérisa par une baisse moyenne de 0,4ºC pendant un an sur l’ensemble de la Terre. En 1815, l’explosion, en Indonésie, du volcan Tambora a transformé, en Europe, l’été en une saison froide et pluvieuse. La disparition des dinosaures reste associée à l’idée d’un événement conjoncturel de ce genre. À ces événements isolés s’ajoutent des phénomènes bio-physiques chroniques comme les émissions de GES par les tourbières ou par les combustions aériennes ou souterraines spontanées qui pèsent aussi sur l’ensemble des émissions.

En résumé, ce qui a, non sans raison, frappé les chercheurs, c’est l’inflexion récente de la courbe des températures et son parallélisme avec l’émission des GES. Cette corrélation donne crédit à une présomption de relation causale entre les deux phénomènes, mais ne lève pas les incertitudes portant sur deux points décisifs : la compréhension des effets systémiques des diverses causes externes au système climatique ; le poids des logiques non anthropiques. Ces limites ne conduisent certainement pas à prendre à la légère le réchauffement actuel, mais il suggère une triple modestie : ne pas surestimer nos connaissances, ne pas surestimer la puissance humaine et, à la rencontre de ces deux éléments, ne pas surestimer notre capacité à gérer le climat de la planète.

Cela conduit à deux options théoriques concernant la relation entre action humaine et changement climatique. Soit il n’existe pas de relation univoque entre les deux phénomènes, ce que tout le monde admet, mais dans ce cas, il est tout de même important d’en savoir plus sur les mécanismes à l’œuvre. Soit d’autres causes sont impliquées et il faudrait bien être capable de les identifier, les deux hypothèses n’étant pas incompatibles. En tout état de cause, ce que nous évaluons mal c’est les conditions d’un retour à l’équilibre ou au contraire d’une bifurcation catastrophique du système climatique. Si l’on considère, par exemple, la possible élévation du niveau de la mer, les scénarios pris en compte par le GIEC prévoyaient entre 10 et 85 cm d’augmentation en 2001. ce qui représente un écart considérable du point de vue des conséquences pratiques : à un extrême, relativement peu d’effets, cantonnés dans quelques régions du globe ; à l’autre, une vraie catastrophe écologique. La fourchette s’est réduite en 2007 à 0,18-0,59 pour 2100, ce qui tempère sensiblement le danger. Avec ces valeurs, on se trouve en situation de risque mais pas de désastre majeur. Ce qu’on sait réellement, c’est que le xxe siècle a vu une élévation moyenne, toutes origines (eustatiques mais aussi epéirogéniques) confondues, de 1,5 mm/an, alors qu’elle était de 10 mm/an entre –15.000 et –6.000.

Questions sans réponses et commensuration sauvage.

Dans ce contexte, le débat public est structuré par un problème difficile à résoudre. La recherche d’une connaissance suffisante pour permettre de prendre les décisions appropriées suggère de prendre son temps. Inversement, l’ampleur du risque encouru conduit à agir vite.

De fait, se produit une commensuration sauvage entre connaissance du risque et valeur du risque. C’est un processus que nous connaissons par ailleurs dans l’évaluation du risque lui-même : danger et aléa tendent à être multipliés l’un par l’autre, donnant des équivalents politiques entre une catastrophe terrible mais peu probable (comme l’explosion d’une centrale nucléaire) et des nuisances assurées mais limitées (comme les maladies respiratoires liées à la circulation des véhicules à carburant fossile). Dans ce cas du réchauffement planètaire, ce n’est pas seulement la valeur du risque qui fait question, c’est aussi la fiabilité de son évaluation. Si c’est loin d’être l’hypothèse la plus sérieuse, on ne peut totalement exclure que l’augmentation anthropique des émissions de GES n’ait finalement aucun effet alarmant sur le climat. Même dans le cas d’un « consensus » sur l’existence de cette relation causale, dont on peut douter de la valeur dans le domaine de la science (cf. [Galam, 2007]), les prévisions divergent lourdement sur l’ampleur du risque et sur ses dynamiques. Les modèles les plus récents considèrent qu’une concentration de 450 ppm de CO2 se traduirait par une augmentation de 2ºC de la température de la moyenne, par rapport à un point origine situé dans les années 1980, provoquerait des dégâts lourds sur la vie des hommes. La force de ces chiffres simples est justement la simplicité. Ce genre de « traduction » est sans doute rendue nécessaire par l’écart de compétence scientifique entre chercheurs et grand public. Il a aussi l’inconvénient de transformer un débat ouvert en martèlement positiviste, un recherche tâtonnante en vérité révélée. En pratique, l’incertitude a jusqu’à présent été gérée sous la forme d’une hésitation et d’une action limitée, comme si l’on faisait une moyenne entre la valeur du risque et les limites de son évaluation. Le Protocole de Kyoto (1997), qui a lui-même été contesté dans son principe par certains acteurs, comme les États-Unis, apparaît comme un compromis qui n’aurait guère de sens si le diagnostic était clair.

Tout se passe comme si le caractère extrêmement inquiétant de ce qui découle de ce que nous savons conduisait à compenser par un régime de vérité idéologique les lacunes de la science.

Le résultat est que les chercheurs eux-mêmes tendent à proposer des agrégats discursifs qui associent de manière implicite des énoncés de nature scientifique dont les faiblesses et les contradictions sont occultées et des convictions politiques, qui renvoient à des postulats éthiques, esthétiques ou métaphysiques n’entrant pas dans le cadre de la réfutabilité des propositions. Plus la conscience se transforme en angoisse, plus ces agrégats deviennent des « boîtes noires » difficiles à ouvrir, et plus les nouvelles informations apportées par la recherche se présentent comme des coups, politiques et médiatiques, qui brouillent plus qu’ils n’éclairent les savoir empirique et le débat théorique. Dans un contexte où nous ne savons pas tout ce que nous aurions besoin de savoir pour prendre une décision raisonnable et juste (ce qui est d’ailleurs le cas général de la décision politique), les arbitrages ne peuvent que relever du politique. Comme l’a montré Bruno Latour [1999], le mélange des genres où les causes, présentées comme purement bio-physiques se trouvent en fait interpénétrées avec des fins, franchement sociétales. Ce « gouvernement des savants » qui ne dit pas son nom transforme des chercheurs brillants en politiciens malhonnêtes et autoritaires. Il comporte des dangers pour la démocratie et l’état de droit dans les pays où ceux-ci existent. Le pouvoir disproportionné donné aux experts par l’atonie du débat public, que certains d’entre eux ne craignent de prendre, place les citoyens hors du jeu, alors même que c’est dans la sphère publique de communication et de délibération que se trouvent les enjeux et les acteurs décisifs.

Cela étant, l’expérience environnementale d’une humanité de plus en plus cultivée et lucide joue son rôle dans le désenchantement de ces complexes de mythe et de science. Ainsi, on aurait pu croire que l’accident de Tchernobyl enterrerait définitivement l’énergie nucléaire. Après un moment de vacillement, c’est le contraire qui se produit. Que le nucléaire civil ait eut pour conséquence quelques centaines ou quelques milliers de morts en cinquante ans d’histoire est désormais vu comme secondaire. Ce qui compte, c’est qu’on est sorti du fantasme et entré dans l’univers de la comparaison. La pesée du risque nucléaire est désormais complexe : d’un côté une énorme dangerosité et un grave problème de temporalité pour les déchets, de l’autre une absence d’émission de GES et une maîtrise de la gestion du risque plutôt meilleure que pour les autres sources d’énergie jusqu’à présent. Dans ce contexte rationnalisé, les arguments très affectifs des anti-nucléaires des années 1970 et 1980 ne sont pas seulement contestés : ils tendent à s’effondrer d’eux-mêmes parce qu’ils se retrouvent hors sujet.

Acteurs et discours hybrides.

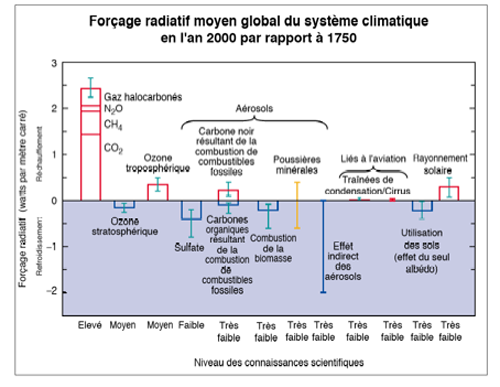

La détermination des causes du réchauffement climatique apparaît décisive pour le contenu et l’orientation des débats. Or il y en a manifestement plusieurs, qui se développent ou au contraire régressent selon des logiques à la fois distinctes mais interreliées au sein du système climatique.

Fig. 7 : Le forçage radiatif d’origine anthropique en 2000, en comparaison de 1750.

Source : Rapport IPCC, figure SPM 3, p. 9.

Source : Rapport IPCC, figure SPM 3, p. 9.

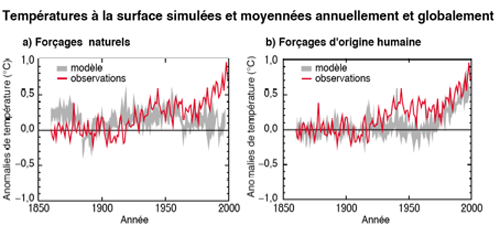

Il est significatif que ceux qui mettent en avant l’action anthropique sont peu diserts sur les émissions naturelles de gaz à effet de serre, pourtant, tous les spécialistes en conviennent, bien plus importantes. Les graphiques ci-dessous montrent que les chercheurs constatent sans pouvoir l’expliquer une contribution plus forte des éléments bio-physiques par rapport à ce qui est modélisé (pour l’essentiel, radiations solaires et événements volcaniques). La bifurcation entre les deux courbes de forçage calculé/observé à partir de 1980 sur le graphique de gauche est spectaculaire. On retrouve aussi, sur le graphique de droite, le décrochage déjà signalé plus haut entre 1940 et 1980, qui pose clairement le problème de nos capacités d’analyse et, en conséquence, de prédiction.

Fig. 8 : Modélisation des anomalies de température selon leur origine, naturelle ou anthropique.

Source : Rapport IPCC, figures SPM 4 a et b, p. 10.

Source : Rapport IPCC, figures SPM 4 a et b, p. 10.

Les allusions à la « couche d’ozone » (O3) sont devenues rares dans le débat public ; or l’affaiblissement d’origine anthropique (CFC) de la présence de ce corps dans la stratosphère a des effets négatifs sur les températures. L’irruption de la couche d’ozone dans les années 1980 et 1990 provenait de son association avec la prévision d’un refroidissement général de la planète, concordant avec les observations de la période précédente. Le rôle de l’agriculture est rarement projeté sur le devant de la scène alors que, en matière de dioxyde de carbone (CO2, entre 10et 20% du total), de protoxyde d’azote (NO2, environ 75%) et de méthane (CH4, environ 70%), ces activités pèsent lourdement sur le flux global.

On peut encore citer le cas des événements météorologiques extrêmes (cyclones, inondations, changements de température brutaux,…), dont la relation avec les modèles de changement climatique n’est pas revendiquée actuellement par les climatologues du fait de leur incapacité à opérer ce changement d’échelle spatiale et temporelle, et qui sont pourtant souvent présentés comme la conséquence de modifications structurelles.

Par ailleurs, les éventuels effets positifs du réchauffement sur la vie humaine sont très peu analysés, alors que le problème mérite tout de même d’être posé, et pas seulement pour les régions polaires. Un ensemble de chercheurs suisses regroupés dans l’Organe consultatif sur les changements climatiques (OcCC) et, ProClim la plate forme de l’Académie suisse des sciences naturelles consacré au climat ont produit en 2007 une étude qui simule pour 2050 un réchauffement de 2-3º. Or les effets annoncés sont plutôt contrastés que catastrophiques : la fourniture en eau impose des adaptations liées aux changement dans le calendrier des précipitations, la production d’hydro-électricité est menacée par la faiblesse des étiages mais la demande de chauffage décroît, la biodiversité se déplace, le tourisme souffre en hiver mais profite de l’été, tandis que l’agriculture est franchement bénéficiaire.

Si les experts climatiques en parlent peu, c’est d’abord au nom d’une conception de la pédagogie qui veut éviter aux élèves-citoyens les « complications » inutiles. C’est peut-être aussi parce que, comme cela apparaît dans toute la production du Giec, le postulat implicite est que tout « dérèglement climatique » est forcément dangereux. C’est, pour une part, une idée de bon sens : il ne vaut mieux pas ouvrir une boîte de Pandore dont nous ignorons le contenu. Cependant, il faut bien admettre que l’histoire du climat échappe pour l’essentiel à celle de l’humanité et opposé un climat non anthropisé et bien réglé à un climat anthropisé déréglé est totalement contraire aux observations empiriques. La présentation de la nature comme une réalité bonne parce que fixe ne date pas d’aujourd’hui et elle s’inscrit dans une lignée idéologique puissante en Occident.

Ce déficit d’explicitation provient sans doute de ce que les informations scientifiques qui sortent du monde universitaire pour se présenter sur la scène politique ne sont pas « nues » mais imbriquées dans un projet idéologique dont elles sont difficilement dissociables. On ne se trouve pas toujours, en effet, dans une configuration dans laquelle l’enjeu serait uniquement l’application du principe de précaution et où on chercherait, pragmatiquement, en période d’incertitude et à titre conservatoire, les domaines où il est le plus facile de limiter l’émission de GES. Telle est, en gros, la démarche du protocole de Kyoto (voir plus loin), qui représente certes un aspect non négligeable du traitement politique de l’environnement, mais un aspect seulement. Il en est un autre, à la fois plus diffus et plus brutal, qui correspond à l’instrumentalisation des dispositifs d’expertise à des fins politiques plus ambitieuses.

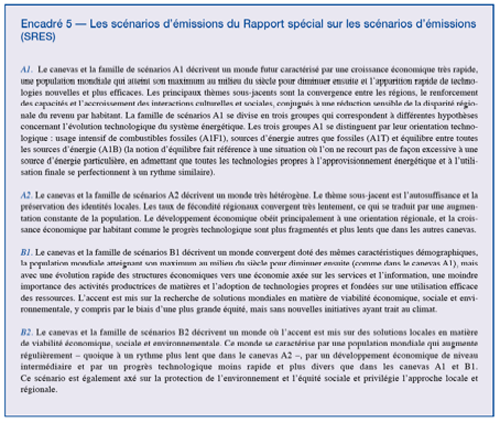

Cet aspect du débat apparaît clairement lorsque l’on examine les scénarios étudiés par le Giec. Il est significatif que le scénario le plus favorable à la protection de l’environnement (B2) associe des éléments sans relations entre eux tels que l’augmentation modérée de la population, le ralentissement du progrès technologique, les surtout les « solutions locales ». Or l’importance de l’échelle mondiale est soulignée dans le cadre du scénario B1. Il serait logique, dans ce cadre, d’y associer une plus forte gouvernementalité mondiale, notamment sur les questions climatiques. L’opposition local/global telle qu’elle est construite dans les couples de scénarios laisse penser que l’émergence du niveau mondial a des effets négatifs sur la conscience environnementale et les mesures qui en découlent. C’est pourtant dans un Monde fragmenté en entités nationales peu soucieuses de l’avenir de la planète que les émissions des GES ont pris leur pente actuelle et de fait, ce n’est pas dans un tel cadre mais dans celui d’une mondialisation rapide que le changement climatique a pu être perçu, analysé par des organismes… tels que le Giec et en partie compensée par des mesures recommandées ou prises au niveau planéaire. On mesure d’ores et déjà les effets extrêmement positifs du désenclavement de la Chine sur l’accélération de la prise de conscience des enjeux écologiques. On sait par ailleurs que 95% du commerce international se fait par voie maritime, sans effets sur l’environnement, alors que les déplacements les plus massivement polluants sont ceux, à faible portée, des voitures et des camions. Le postulat localiste est donc ici asséné sans la moindre démonstration et à l’encontre de toute factualité. Plus généralement, dans l’ensemble des scénarios, la dynamique démographique apparaît une donnée indépendante des logiques sociétales globales (ce que démentent les évolutions récentes) et le mot « développement » n’apparaît qu’associé au mot « économique », ce qui confirme la divergence entre le projet politique du Giec et la problématique du développement durable.

Fig. 9 : Les scénarios de gestion du climat selon le Giec.

Source : Rapport IPCC, encadré 5, p. 59.

Source : Rapport IPCC, encadré 5, p. 59.

Les prophètes de la finitude.

Ce genre d’agrégat n’est pas nouveau. La conscience écologique se fraie un chemin, depuis un demi-siècle, à travers les dénégations aveugles et les prédictions prophétiques.

En 1972, le Rapport Meadows [Meadows et al., 1972] au Club de Rome proposait une vision systémique de l’évolution de l’humanité, vision rendue possible par l’usage de nouveaux modèles mathématiques mis au point au Massachusetts Institute of Technology, qui, pour la première fois, dans ce type d’essai, mettait l’accent sur les contradictions entre économie et écologie. Ce texte demeure une référence pour les écologistes les plus pessimistes.

Les indicateurs choisis étaient la population, les ressources naturelles, les rations alimentaires, la production industrielle, la pollution. La conclusion est que, dans tous les cas de figures, même avec un contrôle des naissances effectif, des ressources naturelles et une production illimitées, l’humanité s’effondrera à cause de l’incompatibilité entre une croissance exponentielle et un système fermé. En fait, l’hypothèse de base est l’impossibilité d’une croissance non prédatrice : épuisement des terres et de l’environnement sont par construction au rendez-vous du développement. La solution préconisée par le Rapport consiste à réduire la production industrielle et à bloquer la consommation et l’espérance de vie, au niveau actuel des pays développés. En fait, toute l’argumentation était biaisée par le fait que l’importance des problèmes augmentait avec la croissance tandis que les solutions à ces problèmes ne suivaient pas. L’économiste Robert Solow nota ainsi que, dans le Rapport, « Population, capital and pollution grow exponentially in all models, but technologies for expanding resources and controlling pollution are permitted to grow, if at all, only in discrete increments ». Le postulat selon lequel la production reste fondamentalement prédatrice de l’environnement n’est jamais mis en cause par les auteurs. L’idée qu’on puisse produire davantage sans épuiser les sols ou polluer l’air est posée comme intenable alors même que l’histoire de l’humanité prouvait le contraire. L’augmentation de la productivité peut être lue comme une capacité à utiliser un matériau bio-physique constant ou en diminution pour en augmenter les ressources. Le fait d’appeler « ressource » le matériau comme si sa contribution à une filière productive était indépendant de l’existence de cette filière est une aberration logique. Sans système d’énergie solaire, le soleil n’est pas une ressource énergétique. La caractéristique d’un système productif (par opposition à un prélèvement prédateur) consiste justement dans le fait que l’invention de la ressource est intégré au processus, et d’autant plus qu’il est davantage producteur et moins prédateur.

Le paradigme de la « finitude » reste en outre profondément daté en ce qu’il réduit la croissance économique à celle du monde agro-industriel : la solution préconisée passe notamment par un décrochage entre production de nourriture et de biens matériels, d’un côté, et services, de l’autre. Or c’est justement ces derniers qui, indépendamment de toute prise de conscience écologique, ont pris une place déterminante dans les systèmes productifs, contribuant à augmenter le rendement économique d’une unité de matière première ou d’énergie. Par ailleurs, les possibilités techniques, économiques et politiques de réduire progressivement les composantes prédatrices de la production étaient déjà visibles à l’époque et sont plus nettes encore aujourd’hui. Enfin, la représentation de la population dérive directement de la vision de Malthus, c’est-à-dire d’un déterminisme naturaliste : la population diminue sa fécondité et décroît quand elle n’a plus rien à manger. L’évolution récente montre exactement l’inverse : c’est l’émergence d’un modèle de développement centré sur l’individu, modèle qui a diffusé des pays les plus développés vers les pays en développement encore plus vite que ne se produisait l’élévation du bien être. La stabilisation de la population, prévue vers 2050, ne doit rien, pour le moment, à quelque épuisement des ressources. L’erreur fondamentale de ce travail consiste à nier la distinction entre ressources naturelles et production humaine et à tout simplement déduire la seconde des premières. La finitude de la planète Terre est incontestable : elle n’est en rien prédictive de celle de l’action humaine. Le champ de rationalité de l’historicité de l’humanité porte justement sur cette différence.

Ainsi, le Rapport Meadows témoigne-t-il d’une mise en scène d’apparence scientifique, avec un fort habillage technologique, de propositions politiques difficiles à étayer, tant elles s’appuient, en fait, sur des choix qu’on peut qualifier de métaphysiques, en ce sens qu’ils traitent du devenir des sociétés en s’affranchissant des connaissances argumentées et réfutables qu’on peut élaborer sur celui-ci.

Les auteurs de The Limits to Growth entretenaient des relations tangentielles avec les sciences sociales. Donella Meadows (1941-2001) avait une formation de chimie et de biophysique, Dennis Meadows est un chimiste reconverti dans la gestion au MIT. Aucun des quatre auteurs n’avait de véritable formation théorique en science économique, moins encore en histoire ou en anthropologie. On retrouve assez souvent sur les questions d’environnement cette posture du chercheur amateur s’aventurant sur le terrain mal connu des sciences sociales pour proférer de manière péremptoire des jugements définitifs sur l’avenir des sociétés. C’est le cas de Garrett Hardin (1915-2003) qui publie dans Science, en 1968, « The Tragedy of the Commons ». Ce zoologue et microbiologiste s’est fait connaître par cet article suivi d’autres textes issus de la même démarche et qu’on peut résumer par le sous-titre d’un de ses articles : « A Biological Approach to Human Problems ». Dans son article de 1968, Hardin cherche à démontrer que l’humanité court à sa perte, si elle continue à se donner le droit de procrééer à sa guise. Prenant la métaphore des « communs » où la libre pâture finit par miner la survie de l’ensemble du cheptel, il conclut que seules des mesures coercitives seront efficaces, car, affirme-t-il, on ne peut compter sur la bonne orientation volontaire des citoyens, à la fois improbable et génératrice d’effets pervers. Ce discours à forte teneur d’une philosophie politique très personnelle a été pourtant perçu et présenté comme une contribution d’un scientifique à l’approche rationnelle des questions écologiques. La mondialisation du débat écologique passe donc par l’existence de « forums hybrides » – des débats entre des personnes excipant de plusieurs types de légitimité – au point que l’hybridité peut se trouver dans la même personne. L’un des enjeux du débat public à venir sera sans doute de formaliser une meilleure distinction entre explicitation scientifique, affirmation éthique et engagement politique.

L’exemple du transport aérien mérite qu’on s’y arrête car il exprime bien le basculement de la démarche scientifique vers des prises de position purement politiques. L’avion présente un cas particulier parmi les moyens de transport, sur trois plans distincts. i Il représente environ 3% de la production anthropique des GES, contre environ 30% pour les transports terrestres, en fait surtout l’automobile. ii Il n’existe pas jusqu’à présent de système de propulsion alternatif aux moteurs fonctionnant au kérosène, qui puisse laisser espérer une réduction massive des émissions dans un proche avenir. iii En ce qui concerne les longs- et parfois les moyens-courriers, il n’existe pas de substitution possible par d’autres moyens de transports. Ces spécificités font que, jusqu’à présent, ce cas a été traité à part et n’a pas été inclus dans le Protocole de Kyoto.

Or on constate que la pression sur les voyageurs pour qu’ils renoncent à l’avion et, en pratique, à tout déplacement en à longue distance connaît un développement incontestable. Alors que l’Union européenne a engagé en décembre 2006 une politique demandant aux compagnies aériennes de limiter leurs émissions et suggérant d’intégrer les transports aériens dans le protocole de Kyoto, certains courants ou attitudes écologistes tentent une mise en cohérence entre prix « trop bas » du transports aérien (les compagnies low-cost sont les plus visées), déplacements « injustifiés » et émission de GES. On voit ainsi un personnage comme Jean-Marc Jancovici, ingénieur-conseil, diplômé de l’École polytechnique et de l’ENST, auteur de plusieurs ouvrages sur le changement climatique et actif dans le débat public, contester sur son blog la légitimité d’ensemble des des Verts français sur le sujet en raison du fait que trois dirigeants étaient allés en vacances (en avion) aux Antilles. Ce site contient surtout un plaidoyer très clair contre le développement du transport aérien et, en général, la mobilité et la vitesse. Jancovici se prononce contre le « tourisme lointain » et pour le « tourisme de proximité » – citoyen du Monde, oui, mais uniquement avec ses voisins. Il prend aussi position contre les subventions à l’élevage mais pour un protectionnisme agricole anti-américain. Enfin, tout en reconnaissant que la densité urbaine est meilleure pour l’économie d’énergie, Jancovici propose une « répartition plus homogène sur le territoire » pour diminuer le « stress » et la criminalité, caractéristique selon lui des grandes villes. Jancovici apparaît comme assez représentatif de l’hybridation science/idéologie dans le sens du modèle de société pré-industriel.

Dans un autre registre, le transport aérien constitue le domaine privilégié de ce que la presse nomme depuis l’été 2006 les « indulgences climatiques ». Il s’agit d’une analogie avec la vente par l’Église, depuis le iiie siècle et jamais abrogée depuis consistant à accorder la « rémission » de péchés et de diminuer la durée de séjour au purgatoire, en échange de « pénitences » souvent traduites en espèces monétaires. Certains commentateurs ont utilisé ce terme à propos du marché du CO2, pour dénoncer la possibilité pour les entreprises du « Nord » d’acheter un « droit à polluer » aux pays du « Sud ». Il est apparu rapidement que cette interprétation était discutable car, à condition d’être correctement étalonné et régulé, ce marché pouvait avoir des effets dissuasifs et « vertueux » sur l’ensemble des acteurs. Le terme « indulgence climatique » s’applique désormais aux individus qui veulent expier les crimes qu’ils commettent en voyageant par avion en subventionnant, par une augmentation volontaire du prix de leur billet, des actions favorables aux énergies renouvelables et rendre ainsi leur péché « climatiquement neutre ». Il s’agit alors d’une réalité d’une autre nature. Les individus (et aucun autre acteur : compagnie aérienne, constructeurs d’avions, autorités politiques,…) s’auto-désignent comme fautifs et s’infligent une peine. Celle-ci est paradoxale : elle n’est pas dissuasive mais persuasive, puisqu’elle permet à ceux qui souhaitent continuer à voyager de le faire sans coût supplementaire, si ce n’est la honte d’un péché sans repentir. Un site zurichois myclimate.org dit bien dans son titre que l’objectif est de faire du climat une affaire individuelle et donc de dépolitiser la question climatique : je pèche, je paie.

Dans ces différents cas de figure, l’attaque frontale contre le droit à la mobilité et la légitimité du mouvement des hommes ne peut être considéré comme un aspect mineur. Si les États autoritaires, dans le passé, ont chercher à marqué leur emprise sur la société en contrôlant les allers et venues de leur sujet, la limitation systématique de la mobilité a été caractéristique de l’ère du paroxysme de l’État ([Lévy, 1997], chapitre 4). Entre 1933 et 1989 les systèmes nazi et, plus encore, soviétique se sont fait une spécialité d’empêcher leurs ressortissants de se déplacer à l’extérieur ou même à l’intérieur de leur territoire. Plus récemment, les représentants officiels de l’autorité religieuse saoudienne avertissent ainsi les candidats au voyage à l’étranger, quel qu’en soit le motif :

« Selon l’islam, il faut se méfier des voyages à l’étranger et me pas en faire si ce n’est pas nécessaire. D’un point de vue islamique, on ne peut acquiescer à un voyage en terre non musulmane qu’au cas où il n’y a pas de solution alternative en terre musulmane. De même, le tourisme n’est convenable qu’à fins de prédication. » Saleh al-Lahidan, président du Haut Conseil Juridique des oulemas saoudiens (Al-Watan/Courrier International, 5-11 avril 2007).

Le fait que les courants écologiques radicaux se polarisent de manière obsessionnelle et sans raison technique convaincante sur le transport aérien long-courrier, qui constitue actuellement le seul moyen pratique de circuler à l’échelle mondiale fait événement, d’autant que ces protagonistes n’expriment pas la moindre inquiétude sur les conséquences de leurs orientations en matière des valeurs et de droits, se tenant à un discours du renoncement et de la punition. La combinaison entre une rhétorique d’apparence scientifique et un message à la fois logiquement incohérent et à forte tonalité expiatoire crée un objet discursif nouveau, qui mérite d’être étudié de près.

Quelle nature pour quelle société ? Trois modèles.

La conscience écologique mondiale marque-t-elle le retour d’un naturalisme conservateur en politique ? Cela paraît intuitivement logique dans la mesure où c’est par un déplacement du centre de gravité des enjeux vers les questions de nature que l’espace de débat politique se se transforme et, à l’échelle mondiale, se construit. Le type de discours sur « la revanche de Gaïa », tenu par un essayiste comme James Lovelock, représente une incontestable ressource argumentative, grâce à sa simplicité et son ancrage historique dans un animisme profond, qui fait bon ménage tant avec le monothéisme qu’avec le « matérialisme » affichés. L’anthropomorphisme d’une Nature à qui on découvre, au-delà de sa puissance, des droits et des attitudes psychologiques, approchés à la fois dans la de l’environnement comme totalité et dans chacune de ses « créatures » correspond à n’en pas douter à un des courants de l’opinion publique mondiale, symétrique de celui qui historicise la relation sociale aux réalités bio-physiques. Il s’agit certes d’une tendance localisée à certaines parties du Monde, notamment en Amérique du Nord et dans l’Europe de tradition protestante. Il ne faut pas cependant en sous-estimer la force, d’une part parce qu’il s’agit de lieux d’émission de forts flux d’influence vers le reste du Monde, d’autre part parce que ce courant peut être considéré comme une version modernisée d’une relation au monde qu’on retrouve dans la plupart des grandes religions. L’opposition aux recherches sur la « manipulation du vivant » fait converger les secteurs conservateurs, en général dominants, des trois grandes religions monothéistes et les écologistes « fondamentalistes » au nom du principe : « On ne touche pas à la nature ».

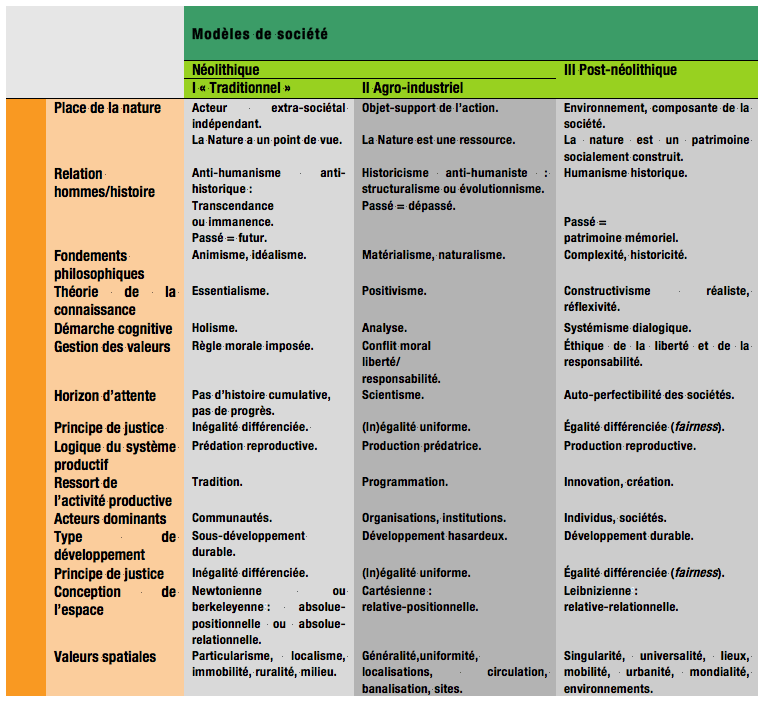

Le tableau ci-dessous présente un état des débats sur les modèles de société Il relie les différentes questions abordées dans ce chapitre : nature, développement, espace et les autres horizons d’attente.

Fig. 10 : Nature, développement, espace et modèles de société.

L’existence et le statut du modèle II fait largement consensus : tous les acteurs s’accordent pour dire qu’il appartient au passé, la seule variabilité étant l’ampleur des critiques qu’il suscite et la vitesse avec laquelle on souhaite en sortir. Ce n’est pas une question académique pour les pays « émergents », pour lesquels ce modèle représente, aujourd’hui, l’option la plus évidente. Ceux-ci se trouvent donc dans un syndrome de dissonance cognitive puisqu’ils assurent leur croissance économique, composante de leur développement grâce au modèle II tout en étant d’ores et déjà orientés vers un modèle de développement. Derrière les visions simplificatrices, qui opposent les industries polluantes censées être inévitables dans les premières phases de développement et/ou pour des sociétés encore pauvres, transparaît un conflit plus profond qui implique l’ensemble du modèle d’orientation de la société. L’importance de la possession d’une automobile comme marqueur profond dans l’imaginaire de l’accès à la société d’abondance ne relève pas d’une contrainte technique mais d’une tendance, de durée de vie plus ou moins longue, mais partout observée dans les pays où une classe moyenne massive émerge : en Europe de l’Est, en Asie, en Amérique latine. La mondialisation rend possible ce qui ne l’a pas été pour l’Europe et l’Amérique du Nord : le synchronisme conflictuel entre deux conceptions antinomiques de la vie sociale. Ainsi en Chine, ce sont les mêmes autorités politiques qui organisent la destruction des vieux quartiers et construisent des voies rapides à leur place et planifient massivement des « villes durables » pour les prochaines décennies.

La spécificité de ce tableau consiste dans l’hypothèse selon laquelle nous sommes en présence de trois options, la sortie du monde industriel pouvant se faire « par l’avant » comme « par l’arrière ». Le tableau fait ainsi apparaître une connexion entre les discours écologistes radicaux et une attitude traditionnelle très ancienne. On peut bien sûr s’interroger sur le statut de ces complexes discursifs schématisés ici. Ne s’agit-il que d’une formalisation excessive d’oppositions beaucoup plus labiles ? Les modèles I et III souvent portés à l’échelle mondiale par les mêmes militants d’une « gauche post-matérialiste »,ne sont-elles pas deux lectures d’un même projet ? Ces questions méritent d’être posées mais on ne peut pas exclure que la réponse soit finalement négative. L’alliance des « progressistes » et des « naturalistes » a peut-être reposé sur un malentendu qui se dissipe maintenant, à la faveur de l’émergence d’une angoisse écologique et de la montée aux extrêmes des termes du débat que cette angoisse rend possible. Tous deux s’opposaient aux lobbies industriels et agricoles, à la tyrannie de l’économisme et des approches atomistes, à l’incapacité de traiter le global, le temps longs et l’espace mondial. Mais cet accord reposait sur des analyses divergentes. D’un côté (modèle III) on a des héritiers de l’écologie libertaire dont Jean Jacob [1999] attribue avec raison la paternité à Serge Moscovici et dont Daniel Cohn-Bendit incarnerait le volet politique dans le cadre franco-allemand. Inversement (modèle I), Jacob fait remonter la filière idéologique du « naturalisme conservateur » au Suisse Robert Hainard (1906-1999), un peintre-philosophe aux sympathies politiques proches de l’extrême droite. Cette vision repose sur le mythe selon lequel la nature offre un ordre que les hommes viennent perturber. Une démarche un peu différente mais convergente est représentée par le courant de la Deep Ecology, lancé par le Norvégien Arne Næss, qui affirme l’égale légitimité, le droit à l’existence et à la reconnaissance pour toutes les formes de vie. Dans cette perspective, la nature possède une valeur intrinsèque, indépendamment de ce qu’en disent les hommes. Aux États-Unis et dans le reste du monde anglophone, de nombreux ouvrages ont mis en avant divers « points de vue », d’« intérêts » et « droits », portés par la nature dans son ensemble ou plus spécifiquement par la Terre, les animaux ou les plantes, et qui sont opposés terme à terme à ceux des hommes en société. Le caractère anti-humaniste est donc ici bien affirmé. Enfin, dans le cas des partis verts ouest-européens, on y observe une forte présence politique d’anciens militants de l’extrême-gauche marxiste qui peuvent « recycler » sur de nouvelles thématiques la posture messianique-eschatologique typique de leurs anciens engagements. Ce faisant, ils activent une filiation, déjà souvent constatée, entre le marxisme et certaines composantes du christianisme.

Dans cet esprit, la critique du « productivisme » qui a constitué un cadre argumentatif fort pour les écologistes depuis les années 1980 peut prendre un sens très particulier si elle sous-tendue par l’idée de la finitude des ressources et sur l’impossibilité fondamentale d’une production non prédatrice. Comme dans le Rapport Meadows, cela se fait au prix d’une lecture très particulière de l’histoire consistant à négliger le caractère historique de ce qu’on appelle « ressource », ce qui permet in fine d’enfermer l’histoire de la production dans une histoire du monde bio-physique. On consultera à ce sujet l’ouvrage sur l’« histoire de l’énergie » [Debeir, Deléage & Hémery, 1986], qui, malgré son titre, déshistoricise le problème de l’énergie et fait de l’anthropie un cas particulier de… l’entropie). L’antinomie avec ceux qui pensent possible une autoperfectibilité des sociétés, capable d’améliorer encore la « productivité » humaine en préservant son environnement est bien réelle, sans doute encore masquée par le fait que l’ennemi commun, agro-industrialiste, n’a pas disparu. À bien y regarder, cependant, on trouve dans cette opposition celle qui, du Moyen-Âge aux Lumières, a mis face à face les « naturalistes » et les « humanistes », la haine de la « mondanité » et l’accueil de la « mondialité », avec Rousseau et Kant comme champions respectifs. On se trouverait alors dans un processus d’activation, favorisé par les circonstances, d’un modèle de société néo-puritain dans lequel les hommes devraient par principe s’excuser moins des dégâts qu’il font à la nature, mais des mauvais penchants qui les y ont conduits.

Cela permet de comprendre pourquoi ce type de démarche refuse d’articuler le problem-raising au problem-solving. L’énergie éolienne a été un cheval de bataille de ces courants lorsqu’elle n’existait pas et qu’elle pouvait être présentée comme une alternative au modèle énergétique en place. Dès qu’elle se développe, quoi qu’à une échelle limitée, elle déclenche une hostilité de ces mêmes milieux qui l’accusent d’être bruyante, de miter les paysages et de pousser à la consommation d’énergie. C’est que la fonction dénonciatrice de naguère s’inscrivait dans un argumentaire visant à limiter l’ensemble des « budgets » énergétiques, considéré comme une orientation fondamentale, indépendamment des problèmes concrets que la consommation d’énergie soulève.

Il conviendra en tout cas de suivre la dynamique des débats au fur et à mesure que, dans l’ensemble des parties du Monde, y compris dans les pays en développement, la vie politique, toutes tendances confondues, s’approprie progressivement la question écologique. On peut penser que le modèle néo-conservateur s’affaiblira, devenant peu à peu anecdotique. On peut, inversement, imaginer que la perception d’une catastrophe imminente donne une force grandissante à ceux qui pourraient dire : « Nous vous l’avions bien dit. » C’est le rôle que s’est attribué Al Gore avec la production et la diffusion mondiale de son film An Inconvenient Truth (2006).

Quelques actions récentes permettent de comprendre comment, concrètement, on peut passer du dire au faire et donner une actualité au modèle néo-pré-industriel. En Allemagne, a été mis en place à partir des années 1980 le retour de la « consigne » pour les bouteilles en verre puis aussi, désormais, celles en plastique, deux produits pour lesquels il existe un système de recyclage bien rodé. Le prix de la bouteille est augmenté d’une petite somme qui sera récupérée à la restitution des bouteilles. Les « canettes » en métal, pourtant encore plus aisément recyclables, sont, elles, proscrites. Enfin, pour éviter les distorsions dans les flux, on est maintenant tenu de retourner les bouteilles dans le magasin où on les a achetées. Le résultat est, d’une part, d’augmenter, dans les deux sens, le poids des produits de consommation courante et donc d’inciter les consommateurs à faire leurs courses en voiture et, d’autre part, de limiter la liberté de choisir son lieu d’achat. Dans certains cantons suisses, chaque sac-poubelle est taxé, avec l’objectif de dissuader la production de déchets. Les personnes qui utilisent des sacs non-taxés et s’en débarrassent (clandestinement) dans les conteneurs publics peuvent voir le contenu de ces sacs ouvert et analysé pour retrouver le contrevenant. Dans les deux cas, l’idéologie sous-jacente n’est pas la protection de l’environnement (qui ne gagne rien dans l’opération) mais la lutte contre les « faux besoins », parmi lesquels est présenté comme emblématique le désir de consommer des produits empaquetés dont l’emballage est destiné à disparaître. Avec les mouvements, relayés depuis longtemps par les pouvoirs publics en faveur d’une diminution des températures dans les logements (20, 19 ou même 18ºC) ou, inversement, du combat, réactivé depuis les canicules ouest-européennes de 2003, contre la climatisation, on a bien un dispositif qui définit le faux-besoin selon deux critères : il génère un confort excessif, et donc malsain, et il est établi selon des procédures qui valorisent le choix individuel. On peut en déduire que les « vrais besoins » devraient correspondre à moins de confort et être fixés autoritairement, indépendamment des demandes du public. Il s’agit ni plus ni moins de retirer au débat public, au nom d’un mixte de considérations techniques et de préceptes moraux, la mission de commensurer les différentes attentes pour établir un compromis potentiellement acceptable. La vie politique consiste justement à trouver une commune mesure à des choses qui, au départ, n’en ont pas : comment penser sur une même échelle, d’une part, 1ºC de température chez toi ou chez moi, le choix d’habiter dans un appartement ou une maison individuelle, d’emprunter les transports publics ou une voiture privée, de choisir le solaire, le nucléaire ou les hydrocarbures pour produire de l’électricité, etc., et, d’autre part, le souci de préserver l’environnement pour aujourd’hui, pour demain, pour dans cent ans ou pour dans cent mille ans. Il ne peut y avoir de réponse mécanique à ces confrontations car le classement et la hiérarchie des choix possibles n’est pas inclus dans les problèmes. Il doit être injecté de l’extérieur, ce que seul le politique, d’autant plus qu’on se trouve dans un cadre démocratique, peut et doit faire. Dans la tentation autoritaire du néo-naturalisme, au contraire, le point d’équilibre est censé être défini par avance, indépendamment de la confrontation des points de vue. On voit ainsi comment la rhétorique technicienne ou scientiste est utilisé pour couper court au débat politique et délivrer des « réponses » fondées sur une morale de la pénitence.

On peut encore citer le cas du papier recyclé, technique intéressante en elle-même mais qui a souvent été présentée comme une alternative à la destruction des forêts alors que la gestion des arbres destinés à la pâte à papier constitue une culture comme une autre qui n’aboutit nullement à l’épuisement de la ressource. Le problème environnemental de l’industrie du papier se situe plutôt dans les émissions des usines de la filière, domaine dans lequel le papier recyclé n’est pas forcément moins pollueur. On peut aussi noter un peu partout en Europe, ainsi qu’au Japon, une défense classiquement protectionniste des agriculteurs nationaux, mais présentée au nom de la supériorité d’une production « locale ».

Ce ne sont là que des événements de portée limitée qui peuvent paraître anecdotiques. Cependant, comme en matière de « relations internationales » depuis les prémices de la Seconde guerre mondiale, l’attitude la plus réaliste ne consiste pas à croire que les choses rentreront spontanément dans l’ordre, mais à prendre les acteurs au sérieux.

Dans ces débats, on voit, en filigrane, affirmer par certains l’incompatibilité structurelle du développement et de la viabilité écologique. C’est ce qui est reproché aux projets de développement par certains courants de la mouvance écologique. Les mesures censées engendrer à la fois une meilleure protection de l’environnement et une croissance économique (tel que l’esquisse par exemple Nicholas Stern (Stern Review on the Economics of Climatic Change, octobre 2006) sont stigmatisés comme l’option du « capitalisme propre ». Si le « capitalisme propre » est jugé « sale », c’est parce qu’il donne l’illusion, pensent certains, que tout peut s’arranger sans dommage. Ce serait alors la fin d’un slogan cher à nombres de tribuns écologiques : « À quoi voulez-vous renoncer ? » et tout l’édifice associant protection de l’environnement et rejet du progrès humain s’effondrerait.

Quel que soit le devenir de chacun de ces modèles et de leur éventuelle hybridation, il apparaît en tout cas que le couplage entre les interrogations sur les natures souhaitables et les dominances sociétales, qui n’est certes pas nouveau connaît une inflexion majeure. L’action sur le corps annonce la question d’une maîtrise considérablement accrue sur la destinée biologique au point de faire de la mort un problème. Elle ouvre aussi, avec le « transhumanisme » le débat sur le lien entre humanité et corporéité humaine. Du côté de l’environnement, c’est la « survie de l’espèce » qui est en jeu, c’est-à-dire l’auto-institution d’une collectivité non communautaire définie, non par le risque qu’elle court ou croit courir, mais par la conscience (awareness) qu’elle en a. Dans les deux cas, les « questions de nature » contribuent puissamment à porter sur la scène les interrogations sur la nature de l’acteur politique « humanité ».